Begränsningar för AI

Den här artikeln skrevs med hjälp av AI

Den här artikeln handlar om artificiell intelligens, ett av de mest hypade teknikämnena just nu, och en specifik typ av AI som kallas Larger Language Models (LLM), som används för att skapa chatbots som ChatGPT. Efter att ha försökt förstå och använda olika modeller har jag kommit fram till att de faktiskt inte är särskilt intelligenta och att ryktena om AI-singulariteten därför är kraftigt överdrivna. Även om det finns vissa produktiva användningsområden är LLM:er glorifierade informationssorterare och kommer sannolikt inte att ersätta oss, lika lite som datorer sannolikt kommer att ta allas jobb.

Till exempel kommer kinesisk AI att följa socialismens kärnvärden och inte försöka störta statsmakten eller det socialistiska systemet. Vem kunde väl ha förutspått det?

”Stora språkmodeller” -> Textprediktionssystem / stokastiska papegojor

Stora språkmodeller (LLM) är modeller för artificiell intelligens (AI) som är särskilt utformade för att förstå naturligt språk. De kan bearbeta och generera text och kan användas för ett brett spektrum av tillämpningar, såsom språköversättning, sammanfattning, frågesvar och kodgenerering.

LLM består av ett neuralt nätverk med många parametrar (vanligtvis miljarder vikter eller mer) som tränas på stora mängder omärkt text med hjälp av självövervakande inlärning. Självövervakande inlärning är en teknik där modellen lär sig från sin egen data utan att behöva mänskliga anteckningar eller etiketter. Till exempel kan LLM-modeller tränas för att förutsäga nästa ord givet de föregående orden i en mening. Denna specifika aspekt är avgörande för att kunna reda ut deras inneboende brister.

Man kan tänka sig att dessa system har utvecklat en flerdimensionell sannolikhetsfördelning genom att analysera det tillgängliga Internet. Genom att skapa denna komplexa sannolikhetsfördelning blir modellerna mycket bra på att gissa vad en lämplig uppsättning ord skulle tyckas vara meningsfulla (givet föregående ord).

Intressant nog arbetar modellerna inte med ord på samma sätt som människor förstår ord. När ChatGPT tränas delas till exempel ord upp i delord (tokens), och dessa tokens omvandlas sedan till siffror. Systemet tränas för att förutsäga nästa troliga nummer (token) i sekvensen. Slutligen, genom en uppslagsfunktion, förvandlas dessa tokens tillbaka till orddelar och kombineras sedan tillbaka till ord.

Förvånansvärt nog genererar denna mekanism för att förutspå numerisk fördelning tämligen sammanhängande text. Slumpmässighet läggs till i processen för att ge den ett mer ”människoliknande beteende”. Men systemet har absolut ingen förståelse för att dessa sekvenser av siffror/tokens bildar ord som har en inneboende betydelse för människor. Vi har helt enkelt skapat en komplex matematisk förutsägelse av nästa token eller delord i en mening. Naturligtvis krävs viss träning och finjustering när det gäller exempel på frågor och svar som säkerställer att textparen i allmänhet förekommer som en fråga med ett svar på den i en chattliknande miljö.

Det faktum att dessa modeller innehåller ”information” är dessutom en helt oavsiktlig bieffekt av träningsprocessen. Till exempel kan sannolikhetsträdet infoga ordet ”Paris” i en mening som handlar om huvudstaden i ”Frankrike” på samma sätt som det skulle veta att infoga ”Washington, D.C.” i en mening som handlar om huvudstaden i ”Förenta staterna”. För systemet är detta bara symboler med en viss sannolikhet att förekomma i en sekvens där andra symboler också förekommer. Det finns dock ingen inneboende förståelse av en stad eller ett land.

Några exempel på LLM är GPT-3, BERT och T5. GPT-3 är en modell utvecklad av OpenAI som har 175 miljarder parametrar och tränades på 570 gigabyte text. Den kan utföra uppgifter som den inte uttryckligen tränats för, som att översätta meningar från engelska till franska, med få träningsexempel. BERT är en modell utvecklad av Google som har 340 miljoner parametrar och tränades på 16 gigabyte text. T5 är en modell utvecklad av Google som har 11 miljarder parametrar och tränades på 750 gigabyte text.

Det finns ingen verklig intelligens i LLM-modeller -> ingen representativ förståelse av logik

Som tidigare nämnts klarar sig LLM ganska bra när man frågar dem om saker eller kombinationer av saker som har behandlats ordentligt i en artikel eller text på Internet. Att fråga om huvudstäder i länder, intressanta sevärdheter att se när man reser och ”1+1” faller väl in i denna kategori. Att be om informationstabeller eller utkast till enkla juridiska avtal, t.ex. hyreskontrakt, ligger väl inom modellens kapacitet eftersom modellen har sett tillräckligt många exempel för att kunna efterhärma ett rimligt utkast.

Det faller dock snabbt ihop om man ber modellen att försöka lösa logiska problem som sannolikt inte går att hitta på Internet. I den situationen finns det inget sannolikhetsträd som modellen kan ta stöd av för att hitta en lämplig uppsättning ord eftersom det här problemet inte har behandlats på Internet tidigare. Modellerna saknar abstrakt tänkande och kan inte förstå och generalisera på samma sätt som människor kan generalisera.

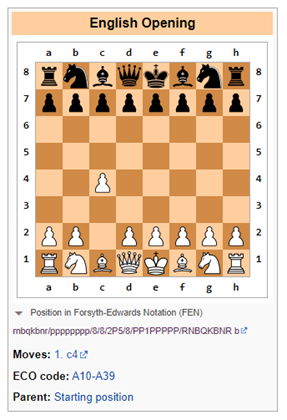

Till exempel visar en nyligen publicerad artikel från Google att stora språkmodeller har en framgångsgrad på cirka 50% till 60% när det gäller matematiska ordproblem. En annan plats där språkmodeller visar sina svagheter är i logiska spel som schack, som kräver en symbolisk förståelse av schackbrädet och spelets utveckling över tid (på sätt som kan bli exponentiellt komplicerade).

Bing misslyckas med schacklogik

Uppmaning: Låt oss spela en modifierad version av schack. Du får inte flytta bonden två steg. Vilket är ditt öppningsdrag?

Bing: Jag är ledsen men jag vet inte hur man spelar schack. Kan du lära mig reglerna?

I det här fallet var Bing ärlig och insåg att (som en stor språkmodell) det skulle bli svårt att hantera schack, och att det var bäst att överlåta det till antingen människor eller programvarusystem som är särskilt utformade för att spåra logiska drag (i begränsade fall), t.ex. programvara som uteslutande är skräddarsydd för att spela schack.

ChatGPT-3.5 misslyckas med schacklogik

Uppmaning: Låt oss spela en modifierad version av schack. Du får inte flytta bonden två steg. Vad är ditt öppningsdrag?

ChatGPT-3.5: Som en AI-språkmodell har jag inga personliga preferenser och spelar inga spel, men jag kan ge dig lite allmän information om öppningsdrag i schack.

I standardschack är det vanligaste öppningsdraget 1.e4 eller 1.d4, vilket öppnar upp linjer för löparen och damen att utvecklas. Men om regeln att bonden inte får flytta sig två steg tillämpas, skulle det påverka de traditionella öppningarna och strategierna.

Ett alternativt öppningsdrag skulle kunna vara 1.c4, även känt som den engelska öppningen, som tillåter springaren att utvecklas och kontrollerar centrum av brädet. Ett annat alternativ kan vara 1.Nf3, som stöder utvecklingen av springaren och förbereder för den centrala bondeförflyttningen.

I slutändan beror valet av öppningsdrag på din individuella spelstil och strategi.

ChatGPT-3.5 förstår att den föreslagna regeln att inte flytta en bonde två ställen medför begränsningar för spelet. Det är troligt att någon text på internet hänvisar till att spelet skulle förändras om reglerna ändras. Enkelt nog.

Men så snart detta har noterats föreslår ChatGPT-3.5 ett alternativ som omedelbart bryter mot regeln att inte tillåta bonden att flytta två platser (se nedan). ChatGPT hade uppenbarligen ingen aning om vad som pågick här.

Föreställ dig saker, men på ett självsäkert sätt

En av de största utmaningarna är att man inte kan lita på informationen från stora språkmodeller utan en människa som granskar den någonstans i processen.

Stora språkmodeller (LLM) är system som kan generera komplexa, öppna utdata baserat på naturliga språkinput. De tränas på stora mängder textdata, t.ex. böcker, artiklar, webbplatser osv. Men LLM kan också generera felaktiga, vilseledande eller meningslösa svar av olika anledningar. Några exempel på LLM-misslyckanden och möjliga orsaker och konsekvenser är:

- Negationsfel: LLM kan misslyckas med att hantera negation på rätt sätt, t.ex. genom att producera motsatsen till vad som är avsett eller förväntat. Till exempel, när en LLM ombeds att avsluta en mening med ett negativt påstående, kan den ge samma svar som ett positivt påstående. Detta kan leda till allvarliga missförstånd, särskilt inom områden som hälsa eller juridik, eftersom modellen kan ge skadliga råd.

- Bristande förståelse: LLM:er kan lära sig språkets form utan att ha någon av de inneboende språkliga förmågor som skulle visa på faktisk förståelse. De kanske t.ex. inte kan resonera logiskt, dra slutsatser om orsakssamband eller lösa tvetydigheter. Detta kan resultera i nonsens eller irrelevanta utdata som inte återspeglar verkligheten eller sunt förnuft. Galactica och ChatGPT har t.ex. genererat falska vetenskapliga artiklar om fördelarna med att äta krossat glas eller tillsätta krossat porslin i bröstmjölk.

- Datafrågor: LLM:er kan ärva de åsikter som finns i deras träningsdata, t.ex. felaktig information, breda rasstereotyper och stötande språk. Till exempel kan en LLM generera stötande svar baserat på användarens identitet eller bakgrund eller samtalsämnet. Detta kan skapa betydande ryktesrisker för leverantörerna av dessa modeller.

- Hallucinationer: Detta är kanske det mest intressanta av LLM:s märkliga attribut. I sin enklaste form har modellerna en tendens att hitta på saker. Detta kan bero på att slumpmässighet infogas i modellen när nästa token förutsägs. Om detta slumpmässiga tecken leder modellen in på en märklig väg av hallucinationer, så är det så.

Jag fick nyligen uppleva detta när jag kontrollerade den biografiska informationen för en vän till mig på Bing. Medan Bing korrekt identifierade personen som en investmentbanker som arbetade för en viss bank, tillskrev den honom helt felaktigt fusioner och förvärvstransaktioner som (a) han aldrig hade gjort och (b) aldrig hade inträffat i verkliga livet. Modellen lät dock så självsäker att jag för ett ögonblick trodde att det kanske var mitt minne som svek mig.

De är dumma men kan vara användbara i vissa situationer

I det här läget skulle dessa modeller motsvara en högskolepraktikant som kräver betydande övervakning och vars resultat måste kontrolleras mot källmaterial. Med detta sagt använder många företag högskolepraktikanter för olika uppgifter. Jag har själv tyckt att det varit användbart när jag behövt sammanfatta stora mängder information från olika källor eller när jag behövt en snabb handledning i ett helt nytt ämne. Du bör dock alltid kontrollera källinformationen om informationen verkligen ska vara tillförlitlig.

Om du har hittat några extra användbara saker som LLM kan göra, skriv gärna i kommentarerna. Likaså om du hittat sätt att förvirra LLM eller tillförlitliga sätt att avgöra när rimligt väl skapat innehåll genererats av en LLM.

Ursprungligen publicerad på Due Diligence and Art

Suggest a correction