Omejitve umetne inteligence

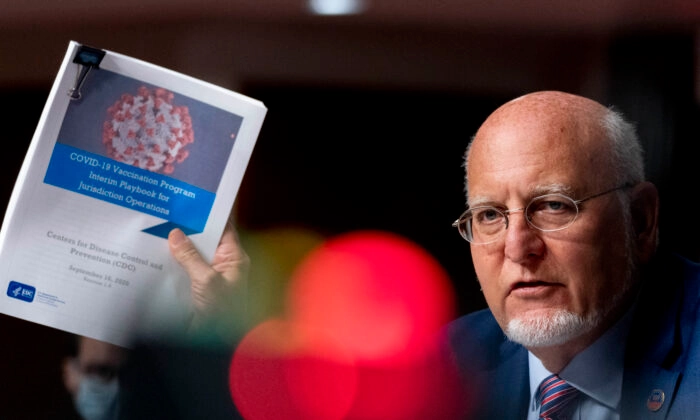

Ta članek je bil napisan s pomočjo UI

Ta članek govori o umetni inteligenci, ki je trenutno ena najbolj aktualnih tehnoloških tem, in o posebni vrsti umetne inteligence, imenovani obsežni jezikovni modeli (OJM, v angleščini LLM, large language models), ki se uporabljajo za ustvarjanje klepetalnikov, kot je ChatGPT. Ko sem poskusila razumeti in uporabiti različne modele, sem ugotovila, da v resnici niso zelo inteligentni in da so zato govorice o dogodku singularnosti umetne inteligence močno pretirane. Čeprav obstajajo nekateri produktivni primeri uporabe, so modeli OJM poveličani sortirniki informacij in nas verjetno ne bodo nadomestili, tako kot računalniki verjetno ne bodo vsem odvzeli delovnih mest.

Kitajska umetna inteligenca bo na primer sledila temeljnim vrednotam socializma in ne bo poskušala zrušiti državne oblasti ali socialističnega sistema. Kdo bi lahko to napovedal?

“Obsežni jezikovni modeli” -> sistemi za napovedovanje besedila / stohastični papagaji

Obsežni jezikovni modeli (OJM) so modeli umetne inteligence (UI), posebej zasnovani za razumevanje naravnega jezika. Lahko obdelujejo in ustvarjajo besedilo ter se lahko uporabljajo za številne aplikacije, kot so prevajanje jezika, povzemanje, odgovarjanje na vprašanja in ustvarjanje kode.

OJM so sestavljeni iz nevronske mreže s številnimi parametri (običajno milijarde uteži ali več), ki se usposabljajo na velikih količinah neoznačenega besedila z uporabo samonadzorovanega učenja. Samonadzorovano učenje je tehnika, pri kateri se model uči iz lastnih podatkov, ne da bi potreboval človeške opombe ali oznake. Na primer, glede na prejšnje besede v stavku je mogoče OJM usposobiti za napovedovanje naslednje besede. Ta poseben vidik je ključnega pomena za odpravo njihovih pomanjkljivosti.

Te sisteme si lahko predstavljamo, kot da so z razčlenjevanjem razpoložljivega interneta razvili večdimenzionalno porazdelitev verjetnosti. Pri ustvarjanju te zapletene verjetnostne porazdelitve postanejo modeli zelo dobri pri ugibanju, kateri primeren niz besed bi se zdel smiseln (glede na prejšnje besede).

Zanimivo je, da modeli ne delujejo na besede na enak način, kot jih razumemo ljudje. Pri usposabljanju ChatGPT se na primer besede razdelijo na delne besede (žetone), ti žetoni pa se nato spremenijo v številke. Sistem je usposobljen za napovedovanje naslednje verjetne številke (žetona) v zaporedju. Na koncu se ti žetoni s pomočjo funkcije iskanja spremenijo nazaj v dele besed in se nato ponovno združijo v besede.

Presenetljivo je, da ta mehanizem za napovedovanje številčne porazdelitve ustvarja precej prepričljivo besedilo. Procesu je dodana naključnost, da se obnaša bolj “človeško”. Vendar pa sistem sploh ne razume, da ta zaporedja števil/točk tvorijo besede, ki imajo za človeka svojstven pomen. Preprosto smo ustvarili zapleteno matematično napovedovalno napravo za naslednji znak ali delno besedo v stavku. Seveda je potrebno nekaj usposabljanja in prilagajanja v zvezi z vzorčnimi pari vprašanj in odgovorov, ki zagotavljajo, da se besedilni pari na splošno pojavljajo kot vprašanje z odgovorom nanj v okolju, podobnem klepetu.

Poleg tega je dejstvo, da ti modeli vsebujejo “informacije”, povsem naključen stranski učinek postopka usposabljanja. Verjetnostno drevo lahko na primer vstavi besedo “Pariz” v stavek, ki obravnava glavno mesto “Francije”, na enak način, kot bi vedelo vstaviti “Washington, D.C.” za stavek, ki obravnava glavno mesto “Združenih držav”. Za sistem so to le žetoni z določeno verjetnostjo, da se pojavijo v zaporedju, v katerem se pojavljajo tudi drugi žetoni. Vendar pa mesto ali država nista pojmovana.

Nekateri primeri OJM so GPT-3, BERT in T5. GPT-3 je model, ki ga je razvil OpenAI, ima 175 milijard parametrov in je bil usposobljen na 570 gigabajtih besedila. Z malo učnimi primeri lahko opravlja naloge, za katere ni bil izrecno usposobljen, na primer prevajanje stavkov iz angleščine v francoščino. BERT je model, ki ga je razvil Google, ima 340 milijonov parametrov in je bil usposobljen na 16 gigabajtih besedila. T5 je model, ki ga je razvil Google, ima 11 milijard parametrov in je bil usposobljen na 750 gigabajtih besedila.

V OJM ni prave inteligence -> ni predstavitvenega razumevanja logike

Kot je bilo že omenjeno, se OJM precej dobro obnesejo, če jih sprašujete o stvareh ali kombinacijah stvari, ki so bile ustrezno obravnavane v članku ali besedilu na internetu. Vprašanja o glavnih mestih držav, zanimivih znamenitostih, ki si jih je treba ogledati na potovanju, in “1+1” lepo spadajo v to kategorijo. Povpraševanje po tabelah z informacijami ali osnutkih preprostih pravnih pogodb, kot so najemne pogodbe, je v okviru zmožnosti modela, saj je model videl dovolj primerov, da lahko kot “papiga” ponovi nazaj dokaj dober osnutek.

Vendar se stvari hitro porušijo, če od modela zahtevate, da poskuša rešiti logične probleme, ki jih verjetno ne boste našli na internetu. V tem primeru model nima verjetnostnega drevesa, ki bi ga lahko preplezal in mu pomagalo najti primeren nabor besed, saj ta problem na internetu še ni bil obravnavan. Modeli nimajo abstraktnega mišljenja ter ne morejo razumeti in posploševati v enakem smislu, kot so ga sposobni posploševati ljudje.

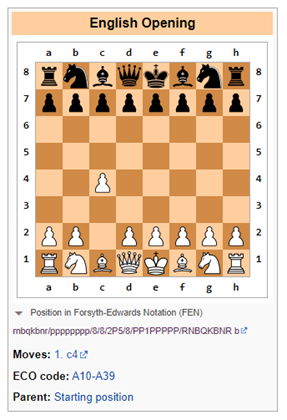

Nedavni Googlov članek na primer kaže, da imajo obsežni jezikovni modeli pri matematičnih besednih problemih približno 50- do 60-odstotno uspešnost. Drugo mesto, kjer jezikovni modeli kažejo svoje slabosti, so logične igre, kot je šah, ki zahtevajo simbolno razumevanje šahovnice in razvijanje igre skozi čas (na načine, ki lahko postanejo eksponentno zapleteni).

Bing je neuspešen pri šahovski logiki

Vprašanje: Igrajmo spremenjeno različico šaha. Kmeta se ne sme premakniti za dve mesti. Katera je tvoja začetna poteza?

Bing: Žal mi je, vendar ne znam igrati šaha. Ali me lahko naučite pravil?

V tem primeru je bil Bing iskren in je spoznal, da bo ukvarjanje s šahom (kot obsežen jezikovni model) težavno in ga je najbolje prepustiti bodisi ljudem bodisi programskim sistemom, posebej zasnovanim za sledenje logičnim potezam (v ozkih primerih uporabe), kot je programska oprema, ki je izključno prilagojena za igranje šaha.

ChatGPT-3.5 neuspešen pri šahovski logiki

Vprašanje: Igrajmo spremenjeno različico šaha. Kmeta ne smete premakniti za dve mesti. Katera je tvoja začetna poteza?

ChatGPT-3.5: Kot jezikovni model umetne inteligence nimam osebnih preferenc in ne igram iger, lahko pa vam zagotovim nekaj splošnih informacij o začetnih potezah v šahu.

V standardnem šahu je najpogostejša začetna poteza 1.e4 ali 1.d4, ki odpira linije za napredovanje škofa in dame. Če pa bi uporabili pravilo, da se kmeta ne sme premakniti za dve mesti, bi to vplivalo na tradicionalne otvoritve in strategije.

Ena od alternativnih začetnih potez bi lahko bila 1.c4, znana tudi kot angleška otvoritev, ki omogoča napredovanje konja in nadzoruje središče šahovnice. Druga možnost bi lahko bila 1.Nf3, ki podpira napredovanje konja in se pripravlja na premik kmetov v sredino.

Na koncu je izbira začetne poteze odvisna od vašega individualnega igralnega sloga in strategije.

ChatGPT-3.5 razume, da predlagano pravilo o prepovedi premikanja kmeta za dve mesti prinaša omejitve pri igranju. Verjetno se v nekaterih besedilih na internetu omenja, da bi se igranje spremenilo, če bi se pravila spremenila. Dovolj preprosto.

Vendar pa ChatGPT-3.5 takoj, ko je to ugotovljeno, predlaga alternativo, ki takoj krši pravilo o prepovedi premikanja kmeta za dve mesti (glej spodaj). Očitno ChatGPT ni imel pojma, kaj se dogaja.

Domišljajo si, a samozavestno

Eden največjih izzivov je nezmožnost zaupanja informacijam iz obsežnih jezikovnih modelov brez pregleda s strani človeka.

Obsežni jezikovni modeli (OJM) so sistemi, ki lahko na podlagi vhodnih podatkov v naravnem jeziku ustvarijo kompleksne, odprte rezultate. Usposobljeni so na velikih količinah besedilnih podatkov, kot so knjige, članki, spletna mesta itd. Vendar pa lahko OJM iz različnih razlogov ustvarijo tudi napačne, zavajajoče ali nesmiselne odgovore. Nekateri primeri napak OJM ter možni vzroki in posledice so naslednji:

- Napake pri zanikanju: zgodi se lahko, da OJM ne uspejo pravilno izvesti negiranja in ustvarijo nasprotno od nameravanega ali pričakovanega. Na primer, ko je OJM zaprošen, da dopolni stavek z negacijo, lahko poda enak odgovor kot pri pritrdilni izjavi. To lahko privede do resnih nesporazumov, zlasti na področjih, kot sta zdravstvo ali pravo, saj lahko model daje škodljive nasvete.

- Pomanjkanje razumevanja: OJM se lahko naučijo oblike jezika, ne da bi imeli kakršne koli jezikovne sposobnosti, ki bi dokazovale dejansko razumevanje. Na primer, morda ne znajo logično razmišljati, sklepati o vzročnosti ali razreševati dvoumnosti. Posledica tega so lahko nesmiselni ali nepomembni rezultati, ki ne odražajo resničnosti ali zdravega razuma. Galactica in ChatGPT sta na primer ustvarila lažne znanstvene članke o prednostih uživanja zdrobljenega stekla ali dodajanja zdrobljenega porcelana v materino mleko.

- Težave s podatki: OJM lahko podedujejo stališča, ki obstajajo v njihovih učnih podatkih, kot so napačne informacije, široki rasni stereotipi in žaljiv jezik. OJM lahko na primer ustvari žaljive odzive na podlagi identitete ali porekla uporabnika ali teme pogovora. To lahko za ponudnike teh modelov povzroči velika tveganja za ugled.

- Halucinacije: To je morda najzanimivejša od nenavadnih lastnosti OJM. V najpreprostejši obliki so modeli nagnjeni k temu, da si stvari izmišljujejo. To je lahko posledica dejstva, da se pri napovedovanju naslednjega žetona v model vnese naključnost. Če ta naključni žeton popelje model na nenavadno pot halucinacij, naj bo tako.

To se mi je nedavno zgodilo, ko sem na portalu Bing preverjala biografske podatke svojega prijatelja. Medtem ko je Bing pravilno identificiral posameznika kot investicijskega bančnika, ki dela za določeno banko, mu je popolnoma napačno pripisal transakcije združitev in prevzemov, ki jih (a) ni nikoli opravil in (b) se niso nikoli zgodile v resničnem življenju. Vendar je model zvenel tako samozavestno, da sem za trenutek pomislila, da mi morda peša spomin.

Neumni so, vendar so lahko v nekaterih primerih koristni

Na tej točki bi te modele ocenili na raven pripravnika na fakulteti, ki potrebuje precejšen nadzor in katerega rezultate je treba preveriti glede na izvorno gradivo. Glede na to številna podjetja za različne naloge uporabljajo univerzitetne pripravnike. Ugotovila sem, da je to koristno zlasti, kadar moram povzeti precejšnjo količino informacij iz različnih virov ali kadar bi rad dobila hitro navodilo o povsem novem predmetu. Vendar pa morate vedno preveriti informacije iz vira, če morajo biti informacije resnično zanesljive.

Če ste našli še kakšno dodatno koristno stvar, ki jo lahko naredijo OJM, jo objavite v komentarjih. Prav tako, če ste našli načine, kako zmesti OJM, ali zanesljive načine za ugotavljanje, kdaj je dokaj dobro ustvarjeno vsebino ustvaril OJM.

Prvotno objavljeno na portalu Due Diligence and Art

Suggest a correction