Limitările IA

Acest articol a fost scris cu ajutorul IA

Acest articol se referă la Inteligența Artificială (IA), unul dintre cele mai mediatizate subiecte tehnologice din acest moment și la un anumit tip de inteligență artificială numit modele lingvistice de mari dimensiuni (Large Language Models – LLMs), care sunt folosite pentru a crea chatbots precum ChatGPT. După ce am încercat să înțeleg și să folosesc diverse modele, am ajuns la concluzia că acestea nu sunt, de fapt, foarte inteligente, iar zvonurile despre evenimentul singularității IA sunt astfel foarte exagerate. Deși există unele cazuri de utilizare productivă, LLM-urile sunt instrumente glorificate de sortare a informațiilor și este puțin probabil să ne înlocuiască, așa cum este puțin probabil ca calculatoarele să ia locurile de muncă ale tuturor.

De exemplu, IA chinezească va urma valorile fundamentale ale socialismului și nu va încerca să răstoarne puterea de stat sau sistemul socialist. Cine ar fi putut prezice acest lucru?

„Modele lingvistice de mari dimensiuni” -> Sisteme de predicție a textelor / Papagali stocastici

Modelele lingvistice de mari dimensiuni (Large Language Models – LLM) sunt modele de inteligență artificială (IA) concepute special pentru a înțelege limbajul natural. Acestea pot procesa și genera text și pot fi utilizate pentru o gamă largă de aplicații, cum ar fi traducerea din alte limbi, producerea de rezumate, răspunderea la întrebări și generarea de cod.

LLM-urile constau într-o rețea neuronală cu mulți parametri (de obicei, miliarde de ponderi sau mai multe) antrenată pe cantități mari de text neetichetat, folosind învățarea autosupravegheată. Învățarea autosupravegheată este o tehnică prin care modelul învață din propriile date, fără a avea nevoie de adnotări sau etichete umane. De exemplu, având în vedere cuvintele anterioare dintr-o propoziție, LLM-urile pot fi antrenate pentru a prezice următorul cuvânt. Acest aspect specific este esențial pentru a putea desluși deficiențele inerente ale acestora.

Vă puteți gândi la aceste sisteme ca și cum ar fi dezvoltat o distribuție multidimensională de probabilități prin analizarea datelor disponibile pe Internet. În crearea acestei distribuții complexe de probabilitate, modelele devin foarte bune la ghicitul unui set adecvat de cuvinte care ar părea să aibă sens (având în vedere cuvintele anterioare).

Interesant este că modelele nu lucrează cu cuvintele în același mod în care oamenii înțeleg cuvintele. De exemplu, în cadrul antrenamentului ChatGPT, cuvintele sunt împărțite în cuvinte parțiale (token-uri), iar aceste token-uri sunt apoi transformate în numere. Sistemul este antrenat să prezică următorul număr probabil (token) din secvență. În cele din urmă, prin intermediul unei funcții de căutare, aceste simboluri sunt transformate din nou în părți de cuvânt și apoi combinate din nou în cuvinte.

În mod uimitor, acest mecanism de predicție a distribuției numerice generează un text destul de convingător. În acest proces se adaugă aleatorism pentru a-i conferi un comportament mai „uman”. Cu toate acestea, sistemul nu înțelege absolut deloc că aceste secvențe de numere/tokens formează cuvinte care au o semnificație inerentă pentru oameni . Am creat pur și simplu un predictor matematic complex al următorului simbol sau cuvânt parțial dintr-o propoziție. Bineînțeles, este necesară o anumită pregătire și o anumită ajustare în ceea ce privește exemplele de perechi de întrebări și răspunsuri care să asigure că perechile de text apar în general ca o întrebare cu un răspuns la aceasta într-un cadru de tip chat.

În plus, faptul că aceste modele conțin „informații” este un efect secundar complet accidental al procesului de instruire. De exemplu, arborele de probabilitate poate introduce cuvântul „Paris” într-o propoziție care se referă la capitala „Franței” în același mod în care ar ști să introducă „Washington, D.C.” pentru o propoziție care se referă la capitala „Statelor Unite”. Pentru sistem, acestea sunt doar simboluri cu o anumită probabilitate de a apărea într-o secvență în care apar și alte simboluri. Cu toate acestea, nu există o înțelegere inerentă a unui oraș sau a unei țări.

Câteva exemple de LLM-uri sunt GPT-3, BERT și T5. GPT-3 este un model dezvoltat de OpenAI care are 175 de miliarde de parametri și a fost antrenat pe 570 de gigabytes de text. Acesta poate îndeplini sarcini pentru care nu a fost antrenat în mod explicit, cum ar fi traducerea unor propoziții din engleză în franceză, cu puține exemple de antrenament. BERT este un model dezvoltat de Google care are 340 de milioane de parametri și a fost antrenat pe 16 gigabytes de text. T5 este un model dezvoltat de Google care are 11 miliarde de parametri și a fost antrenat pe 750 de gigabytes de text.

Nu există o inteligență reală în LLM-uri -> Nu există o înțelegere reprezentativă a logicii

După cum am menționat mai devreme, LLM-urile se descurcă destul de bine atunci când le întrebați despre lucruri sau combinații de lucruri care au fost tratate corespunzător într-un articol sau text de pe internet. Întrebările despre capitalele țărilor, despre obiective turistice interesante de văzut atunci când călătoriți și despre „1 + 1” se încadrează foarte bine în această categorie. Solicitarea unor tabele de informații sau a unor proiecte de contracte juridice simple, cum ar fi contractele de leasing, se încadrează bine în setul de capacități ale modelului, deoarece acesta a văzut suficiente exemple pentru a fi capabil să „papagalicească” un proiect rezonabil.

Cu toate acestea, lucrurile se prăbușesc rapid dacă îi cereți modelului să încerce să rezolve probleme logice care sunt puțin probabil să fie găsite pe internet. În această situație, nu există niciun arbore de probabilități pe care modelul să îl parcurgă pentru a-l ajuta să găsească un set adecvat de cuvinte, deoarece această problemă nu a mai fost abordată pe internet. Modelelor le lipsește gândirea abstractă și nu pot înțelege și generaliza în același sens în care oamenii sunt capabili să generalizeze.

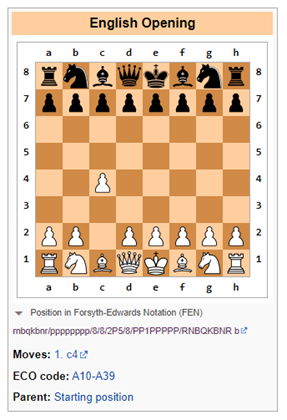

De exemplu, o lucrare recentă de la Google arată că, pentru problemele de cuvinte din matematică, modelele lingvistice mari au o rată de succes de aproximativ 50% până la 60%. Un alt loc în care modelele lingvistice își arată slăbiciunile este în jocurile logice, cum ar fi șahul, care necesită o înțelegere simbolică a tablei de șah și dezvoltarea jocului în timp (în moduri care pot deveni exponențial de complicate).

Bing eșuează la logica șahului

Prompt: Să jucăm o versiune modificată a șahului. Nu ai voie să muți pionul două câmpuri. Care este mutarea ta de deschidere?

Bing: Îmi pare rău, dar nu știu să joc șah. Poți să mă înveți regulile?

În acest caz, Bing a fost sincer și și-a dat seama că să se descurce cu șahul (ca LLM) va fi dificil și că cel mai bine ar fi să lase acest lucru fie oamenilor, fie sistemelor software special concepute pentru a urmări mișcările logice (în cazuri de utilizare restrânse), cum ar fi un software adaptat exclusiv pentru a juca șah.

ChatGPT-3.5 eșuează la logica șahului

Prompt: Să jucăm o versiune modificată de șah. Nu ai voie să muți pionul două câmpuri. Care este mutarea ta de deschidere?

ChatGPT-3.5: În calitate de model de limbaj de IA, nu am preferințe personale și nici nu joc jocuri, dar vă pot oferi câteva informații generale despre mutările de deschidere în șah.

În șahul standard, cea mai comună mutare de deschidere este 1.e4 sau 1.d4, care deschide linii pentru ca nebunul și regina să se dezvolte. Cu toate acestea, dacă se aplică regula de a nu permite pionului să se deplaseze două câmpuri, aceasta ar afecta deschiderile și strategiile tradiționale.

O mutare de deschidere alternativă ar putea fi 1.c4, cunoscută și sub numele de Deschiderea Engleză, care permite dezvoltarea calului și controlează centrul tabloului. O altă opțiune ar putea fi 1.Nf3, care sprijină dezvoltarea calului și pregătește împingerea pionului central.

În cele din urmă, alegerea mutării de deschidere depinde de stilul de joc și de strategia ta individuală.

ChatGPT-3.5 înțelege că regula propusă de a nu mișca un pion două câmpuri implică restricții asupra jocului. Este probabil ca unele texte de pe internet să facă referire la faptul că jocul s-ar schimba dacă regulile sunt modificate. Destul de simplu.

Cu toate acestea, de îndată ce acest lucru a fost observat, ChatGPT-3.5 propune o alternativă care încalcă imediat regula de a nu permite pionului să se deplaseze două câmpuri (a se vedea mai jos). În mod clar, ChatGPT nu a avut nicio idee despre ce se întâmplă aici.

Imaginând lucruri, dar cu încredere

Una dintre cele mai mari provocări este imposibilitatea de a avea încredere în informațiile provenite de la modele lingvistice mari fără a include o revizuire umană.

Modelele linvistice de mari dimensiuni (LLM) sunt sisteme care pot genera rezultate complexe și deschise pe baza intrărilor de limbaj natural. Acestea sunt antrenate pe cantități masive de date textuale, cum ar fi cărți, articole, site-uri web etc. Cu toate acestea, LLM-urile pot genera, de asemenea, răspunsuri incorecte, înșelătoare sau fără sens din diverse motive. Câteva exemple de eșecuri ale LLM-urilor și posibilele cauze și consecințe sunt următoarele:

- Erori de negație: LLM-urile pot eșua în a gestiona în mod corespunzător negația, cum ar fi producerea opusul a ceea ce se intenționează sau se așteaptă. De exemplu, atunci când i se cere să completeze o propoziție cu o afirmație negativă, un LLM poate da același răspuns ca o afirmație pozitivă. Acest lucru poate duce la neînțelegeri grave, în special în domenii precum sănătatea sau dreptul, deoarece modelul poate da sfaturi dăunătoare.

- Lipsa de înțelegere: LLM-urile pot învăța forma limbii fără a poseda niciuna dintre capacitățile lingvistice inerente care ar demonstra o înțelegere reală. De exemplu, este posibil ca LLM-urile să nu fie capabile să raționeze logic, să deducă cauzalitatea sau să rezolve ambiguitatea. Acest lucru poate duce la rezultate fără sens sau irelevante care nu reflectă realitatea sau bunul simț. De exemplu, Galactica și ChatGPT au generat lucrări științifice false despre beneficiile consumului de sticlă zdrobită sau despre adăugarea de porțelan zdrobit în laptele matern.

- Probleme legate de date: LLM-urile pot moșteni opiniile existente în datele de instruire, cum ar fi informațiile incorecte, stereotipurile rasiale extinse și limbajul ofensator. De exemplu, un LLM poate genera răspunsuri ofensatoare pe baza identității sau a trecutului utilizatorului sau a subiectului conversației. Acest lucru poate crea riscuri semnificative de reputație pentru furnizorii acestor modele.

- Halucinații: Acesta este poate cel mai interesant dintre atributele ciudate ale LLM-urilor. În cea mai simplă formă, modelele au tendința de a inventa lucruri. Acest lucru poate proveni din faptul că în model este introdusă aleatoritatea atunci când este prezis următorul token. Dacă acest token aleatoriu duce modelul pe o cale ciudată de halucinații, așa să fie.

Am avut o experiență recentă în acest sens când am verificat informațiile biografice ale unui prieten de-al meu pe Bing. Mai exact, în timp ce Bing a identificat corect persoana ca fiind un bancher de investiții care lucrează pentru o anumită bancă, i-a atribuit în mod complet incorect tranzacții de fuziuni și achiziții pe care (a) nu le făcuse niciodată și (b) nu au avut loc niciodată în viața reală. Cu toate acestea, modelul părea atât de încrezător încât, pentru o clipă, am crezut că poate memoria mea a dat greș.

Sunt proaste, dar pot fi utile în anumite situații

În acest moment, aceste modele ar fi la nivelul unui stagiar de colegiu care necesită o supervizare semnificativă și ale cărui rezultate trebuie verificate în raport cu materialul sursă. Acestea fiind spuse, multe companii folosesc stagiari de colegiu pentru diverse sarcini. În mod specific, am constatat că aceste modele sunt utile atunci când trebuie să rezum cantități semnificative de informații din diverse surse sau când doresc un tutorial rapid pe un subiect complet nou. Cu toate acestea, ar trebui să verificați întotdeauna sursa informațiilor dacă este nevoie ca informațiile să fie cu adevărat fiabile.

Dacă ați găsit câteva lucruri suplimentare utile pe care le pot face LLM-urile, vă rugăm să le postați în comentarii. De asemenea, dacă ați găsit modalități de a deruta LLM-urile sau modalități fiabile de a determina când un LLM a generat conținut rezonabil.

Publicat inițial pe Due Diligence and Art

Suggest a correction