Περιορισμοί της τεχνητής νοημοσύνης (AI)

Αυτό το άρθρο γράφτηκε με τη βοήθεια της AI

Αυτό το άρθρο αφορά την Τεχνητή Νοημοσύνη, ένα από τα πιο πολυσυζητημένα τεχνολογικά θέματα αυτή τη στιγμή και έναν συγκεκριμένο τύπο Τεχνητής Νοημοσύνης που ονομάζεται Μεγάλο Γλωσσικό Μοντέλο (LLM), το οποίο χρησιμοποιείται για τη δημιουργία chatbots όπως το ChatGPT. Αφού προσπάθησα να κατανοήσω και να χρησιμοποιήσω διάφορα μοντέλα, κατέληξα στο συμπέρασμα ότι στην πραγματικότητα δεν είναι πολύ έξυπνα και ότι οι φήμες για το γεγονός της μοναδικότητας της ΤΝ είναι συνεπώς σε μεγάλο βαθμό υπερβολικές. Ενώ υπάρχουν ορισμένες περιπτώσεις παραγωγικής χρήσης, τα LLM είναι εξιδανικευμένοι ταξινομητές πληροφοριών και είναι απίθανο να μας αντικαταστήσουν, όσο είναι πιθανό και οι υπολογιστές να πάρουν τις δουλειές όλων μας.

Για παράδειγμα, η κινεζική Τεχνητή Νοημοσύνη θα ακολουθήσει τις βασικές αξίες του σοσιαλισμού και δεν θα επιχειρήσει να ανατρέψει την κρατική εξουσία ή το σοσιαλιστικό σύστημα. Ποιος θα μπορούσε να το προβλέψει αυτό;

“Μεγάλα γλωσσικά μοντέλα” -> Συστήματα πρόβλεψης κειμένου / Στοχαστικοί παπαγάλοι

Τα μεγάλα γλωσσικά μοντέλα (LLM) είναι μοντέλα τεχνητής νοημοσύνης (AI) ειδικά σχεδιασμένα για την κατανόηση της φυσικής γλώσσας. Μπορούν να επεξεργάζονται και να παράγουν κείμενο και μπορούν να χρησιμοποιηθούν για ένα ευρύ φάσμα εφαρμογών, όπως η γλωσσική μετάφραση, η περίληψη, η απάντηση ερωτήσεων και η παραγωγή κώδικα.

Τα LLM αποτελούνται από ένα νευρωνικό δίκτυο με πολλές παραμέτρους (συνήθως δισεκατομμύρια βάρη ή και περισσότερα) που εκπαιδεύονται σε μεγάλες ποσότητες μη επισημασμένου κειμένου με τη χρήση αυτοεποπτευόμενης μάθησης. Η αυτο-εποπτευόμενη μάθηση είναι μια τεχνική όπου το μοντέλο μαθαίνει από τα δικά του δεδομένα χωρίς να απαιτεί ανθρώπινες επισημάνσεις ή ετικέτες. Για παράδειγμα, δεδομένων των προηγούμενων λέξεων σε μια πρόταση, τα LLM μπορούν να εκπαιδευτούν για να προβλέψουν την επόμενη λέξη. Αυτή η συγκεκριμένη πτυχή είναι κρίσιμη για να μπορέσουμε να ξεμπερδέψουμε με τις εγγενείς ελλείψεις τους.

Μπορείτε να σκεφτείτε ότι αυτά τα συστήματα έχουν αναπτύξει μια πολυδιάστατη κατανομή πιθανοτήτων αναλύοντας το διαθέσιμο Διαδίκτυο. Κατά τη δημιουργία αυτής της πολύπλοκης κατανομής πιθανοτήτων, τα μοντέλα γίνονται πολύ καλά στο να μαντεύουν ποιο κατάλληλο σύνολο λέξεων θα φαινόταν να έχει νόημα (δεδομένων των προηγούμενων λέξεων).

Είναι ενδιαφέρον ότι τα μοντέλα δεν λειτουργούν με τις λέξεις με τον ίδιο τρόπο που οι άνθρωποι κατανοούν τις λέξεις. Για παράδειγμα, κατά την εκπαίδευση του ChatGPT, οι λέξεις χωρίζονται σε μερικές λέξεις (tokens) και αυτά τα tokens μετατρέπονται στη συνέχεια σε αριθμούς. Το σύστημα εκπαιδεύεται να προβλέπει τον επόμενο πιθανό αριθμό (token) στην ακολουθία. Τέλος, μέσω μιας συνάρτησης αναζήτησης, αυτά τα σημεία μετατρέπονται ξανά σε τμήματα λέξεων και στη συνέχεια συνδυάζονται ξανά σε λέξεις.

Είναι εκπληκτικό ότι αυτός ο μηχανισμός πρόβλεψης αριθμητικής κατανομής παράγει αρκετά πειστικό κείμενο. Η τυχαιότητα προστίθεται στη διαδικασία για να της προσδώσει πιο “ανθρώπινη συμπεριφορά”. Ωστόσο, το σύστημα δεν έχει καμία απολύτως αντίληψη ότι αυτές οι ακολουθίες αριθμών/κομματιών σχηματίζουν λέξεις που έχουν εγγενές νόημα για τους ανθρώπους. Έχουμε απλώς δημιουργήσει έναν πολύπλοκο μαθηματικό προγνωστικό μηχανισμό για το επόμενο σύμβολο ή την επόμενη μερική λέξη σε μια πρόταση. Φυσικά, απαιτείται κάποια εκπαίδευση και προσαρμογή όσον αφορά τα ζεύγη δειγμάτων ερωτήσεων και απαντήσεων που διασφαλίζουν ότι τα ζεύγη κειμένου εμφανίζονται γενικά ως ερώτηση με απάντηση σε αυτήν σε ένα περιβάλλον που μοιάζει με συνομιλία.

Επιπλέον, το γεγονός ότι αυτά τα μοντέλα περιέχουν “πληροφορίες” είναι μια εντελώς τυχαία παρενέργεια της διαδικασίας εκπαίδευσης. Για παράδειγμα, το δέντρο πιθανοτήτων μπορεί να εισάγει τη λέξη “Παρίσι” σε μια πρόταση που αφορά την πρωτεύουσα της “Γαλλίας” με τον ίδιο τρόπο που θα ήξερε να εισάγει τη λέξη “Ουάσινγκτον” για μια πρόταση που αφορά την πρωτεύουσα των “Ηνωμένων Πολιτειών”. Για το σύστημα, πρόκειται απλώς για μάρκες που έχουν μια ορισμένη πιθανότητα να εμφανιστούν σε μια ακολουθία όπου εμφανίζονται και άλλες μάρκες. Ωστόσο, δεν υπάρχει καμία εγγενής κατανόηση μιας πόλης ή μιας χώρας.

Ορισμένα παραδείγματα LLM είναι τα GPT-3, BERT και T5. Το GPT-3 είναι ένα μοντέλο που αναπτύχθηκε από την OpenAI, το οποίο έχει 175 δισεκατομμύρια παραμέτρους και εκπαιδεύτηκε σε 570 gigabytes κειμένου. Μπορεί να εκτελέσει εργασίες στις οποίες δεν εκπαιδεύτηκε ρητά, όπως η μετάφραση προτάσεων από τα αγγλικά στα γαλλικά, με λίγα παραδείγματα εκπαίδευσης. Το BERT είναι ένα μοντέλο που αναπτύχθηκε από την Google, το οποίο έχει 340 εκατομμύρια παραμέτρους και εκπαιδεύτηκε σε 16 gigabytes κειμένου. Το T5 είναι ένα μοντέλο που αναπτύχθηκε από την Google, το οποίο έχει 11 δισεκατομμύρια παραμέτρους και εκπαιδεύτηκε σε 750 gigabytes κειμένου.

Δεν υπάρχει πραγματική νοημοσύνη στα LLM -> Δεν υπάρχει αντιπροσωπευτική κατανόηση της λογικής

Όπως σημειώθηκε προηγουμένως, τα LLM τα πάνε αρκετά καλά όταν τα ρωτάτε για πράγματα ή συνδυασμούς πραγμάτων που έχουν καλυφθεί κατάλληλα σε ένα άρθρο ή κείμενο στο Διαδίκτυο. Οι ερωτήσεις σχετικά με πρωτεύουσες χωρών, ενδιαφέροντα αξιοθέατα που πρέπει να δείτε όταν ταξιδεύετε και το “1+1” εμπίπτουν άνετα σε αυτή την κατηγορία. Το να ζητάτε πίνακες πληροφοριών ή σχέδια απλών νομικών συμβάσεων, όπως μισθώσεις, εμπίπτουν σαφώς στο σύνολο των δυνατοτήτων του μοντέλου, καθώς το μοντέλο έχει δει αρκετά παραδείγματα ώστε να είναι σε θέση να “παπαγαλίσει” ένα λογικό σχέδιο.

Ωστόσο, τα πράγματα καταρρέουν γρήγορα αν ζητήσετε από το μοντέλο να προσπαθήσει να λύσει λογικά προβλήματα που είναι απίθανο να βρεθούν στο Διαδίκτυο. Σε αυτή την περίπτωση, δεν υπάρχει δέντρο πιθανοτήτων που να μπορεί να ανιχνεύσει το μοντέλο για να το βοηθήσει να βρει ένα κατάλληλο σύνολο λέξεων, επειδή το πρόβλημα αυτό δεν έχει καλυφθεί ξανά στο Διαδίκτυο. Τα μοντέλα στερούνται αφηρημένης σκέψης και δεν μπορούν να κατανοήσουν και να γενικεύσουν με την ίδια έννοια που οι άνθρωποι είναι σε θέση να γενικεύσουν.

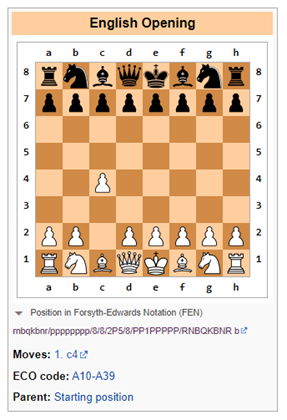

Για παράδειγμα, ένα πρόσφατο έγγραφο της Google δείχνει ότι για μαθηματικά προβλήματα λέξεων, τα μεγάλα γλωσσικά μοντέλα έχουν ποσοστό επιτυχίας περίπου 50% έως 60%. Ένα άλλο σημείο όπου τα γλωσσικά μοντέλα δείχνουν τις αδυναμίες τους είναι τα λογικά παιχνίδια όπως το σκάκι, τα οποία απαιτούν συμβολική κατανόηση της σκακιέρας και ανάπτυξη του παιχνιδιού με την πάροδο του χρόνου (με τρόπους που μπορεί να γίνουν εκθετικά περίπλοκοι).

Το Bing αποτυγχάνει στη λογική του σκακιού

Προτροπή: Ας παίξουμε μια τροποποιημένη έκδοση του σκακιού. Δεν επιτρέπεται να μετακινήσετε το πιόνι κατά δύο θέσεις. Ποια είναι η εναρκτήρια κίνησή σας;

Bing: Λυπάμαι, αλλά δεν ξέρω να παίζω σκάκι. Μπορείς να μου μάθεις τους κανόνες;

Σε αυτή την περίπτωση, το Bing ήταν ειλικρινές και συνειδητοποίησε ότι η ενασχόληση με το σκάκι (ως Μεγάλο Γλωσσικό Μοντέλο) θα ήταν δύσκολη και ότι το καλύτερο είναι να το αφήσει είτε σε ανθρώπους είτε σε συστήματα λογισμικού ειδικά σχεδιασμένα για να παρακολουθούν λογικές κινήσεις (σε στενές περιπτώσεις χρήσης), όπως λογισμικό αποκλειστικά προσαρμοσμένο για να παίζει σκάκι.

Το ChatGPT-3.5 αποτυγχάνει στη λογική του σκακιού

Προτροπή: Ας παίξουμε μια τροποποιημένη έκδοση σκακιού. Δεν επιτρέπεται να μετακινήσετε το πιόνι κατά δύο θέσεις. Ποια είναι η εναρκτήρια κίνησή σας;

ChatGPT-3.5: Ως γλωσσικό μοντέλο τεχνητής νοημοσύνης, δεν έχω προσωπικές προτιμήσεις ούτε παίζω παιχνίδια, αλλά μπορώ να σας δώσω κάποιες γενικές πληροφορίες σχετικά με τις κινήσεις ανοίγματος στο σκάκι.

Στο τυπικό σκάκι, η πιο συνηθισμένη κίνηση ανοίγματος είναι η 1.e4 ή η 1.d4, η οποία ανοίγει γραμμές για την ανάπτυξη του αξιωματικού και της βασίλισσας. Ωστόσο, αν εφαρμοστεί ο κανόνας ότι δεν επιτρέπεται στο πιόνι να μετακινηθεί δύο θέσεις, αυτό θα επηρεάσει τα παραδοσιακά ανοίγματα και τις στρατηγικές.

Μια εναλλακτική κίνηση ανοίγματος θα μπορούσε να είναι το 1.c4, γνωστό και ως Αγγλικό Άνοιγμα, το οποίο επιτρέπει την ανάπτυξη του ίππου και ελέγχει το κέντρο της σκακιέρας. Μια άλλη επιλογή θα μπορούσε να είναι η 1.Nf3, η οποία υποστηρίζει την ανάπτυξη του ίππου και προετοιμάζει την ώθηση του κεντρικού πιόνιου.

Τελικά, η επιλογή της κίνησης ανοίγματος εξαρτάται από το ατομικό σας στυλ παιχνιδιού και τη στρατηγική σας.

Το ChatGPT-3.5 κατανοεί ότι ο προτεινόμενος κανόνας της μη μετακίνησης ενός πιόνιου σε δύο θέσεις επιφέρει περιορισμούς στο παιχνίδι. Είναι πιθανό ότι κάποια κείμενα στο διαδίκτυο αναφέρουν ότι το gameplay θα αλλάξει αν αλλάξουν οι κανόνες. Αρκετά απλό.

Ωστόσο, μόλις αυτό επισημανθεί, το ChatGPT-3.5 προτείνει μια εναλλακτική λύση που παραβιάζει αμέσως τον κανόνα που απαγορεύει στο πιόνι να μετακινηθεί δύο θέσεις (βλ. παρακάτω). Προφανώς, το ChatGPT δεν είχε ιδέα για το τι συνέβαινε εδώ.

Φαντάζεται πράγματα, αλλά με σιγουριά

Μία από τις μεγαλύτερες προκλήσεις είναι η αδυναμία εμπιστοσύνης στις πληροφορίες από μεγάλα γλωσσικά μοντέλα χωρίς ανθρώπινη επανεξέταση.

Τα μεγάλα γλωσσικά μοντέλα (LLM) είναι συστήματα που μπορούν να παράγουν πολύπλοκα, ανοιχτά αποτελέσματα με βάση εισόδους φυσικής γλώσσας. Εκπαιδεύονται σε τεράστιες ποσότητες δεδομένων κειμένου, όπως βιβλία, άρθρα, ιστότοποι κ.λπ. Ωστόσο, τα LLM μπορούν επίσης να παράγουν λανθασμένες, παραπλανητικές ή μη λογικές απαντήσεις για διάφορους λόγους. Ορισμένα παραδείγματα αποτυχιών των LLM και πιθανών αιτιών και συνεπειών είναι τα εξής:

- Σφάλματα άρνησης: Τα LLM μπορεί να αποτύχουν να χειριστούν σωστά την άρνηση, όπως για παράδειγμα να παράγουν το αντίθετο από αυτό που επιδιώκεται ή αναμένεται. Για παράδειγμα, όταν ζητείται από ένα LLM να συμπληρώσει μια πρόταση με μια αρνητική δήλωση, μπορεί να δώσει την ίδια απάντηση με μια θετική δήλωση. Αυτό μπορεί να οδηγήσει σε σοβαρές παρεξηγήσεις, ιδίως σε τομείς όπως η υγεία ή το δίκαιο, καθώς το μοντέλο μπορεί να δώσει επιζήμιες συμβουλές.

- Έλλειψη κατανόησης: Τα LLM μπορεί να μάθουν τη μορφή της γλώσσας χωρίς να διαθέτουν καμία από τις εγγενείς γλωσσικές ικανότητες που θα καταδείκνυαν την πραγματική κατανόηση. Για παράδειγμα, μπορεί να μην είναι σε θέση να συλλογίζονται λογικά, να συμπεραίνουν την αιτιότητα ή να επιλύουν την ασάφεια. Αυτό μπορεί να οδηγήσει σε ανούσιες ή άσχετες εκροές που δεν αντικατοπτρίζουν την πραγματικότητα ή την κοινή λογική. Για παράδειγμα, οι Galactica και ChatGPT έχουν δημιουργήσει ψεύτικες επιστημονικές εργασίες σχετικά με τα οφέλη της κατανάλωσης θρυμματισμένου γυαλιού ή της προσθήκης θρυμματισμένης πορσελάνης στο μητρικό γάλα.

- Ζητήματα δεδομένων: Τα LLM ενδέχεται να κληρονομούν τις απόψεις που υπάρχουν στα δεδομένα εκπαίδευσής τους, όπως λανθασμένες πληροφορίες, ευρεία φυλετικά στερεότυπα και προσβλητική γλώσσα. Για παράδειγμα, ένα LLM μπορεί να παράγει προσβλητικές απαντήσεις με βάση την ταυτότητα ή το υπόβαθρο του χρήστη ή το θέμα της συζήτησης. Αυτό μπορεί να δημιουργήσει σημαντικούς κινδύνους φήμης για τους παρόχους αυτών των μοντέλων.

- Παραισθήσεις: Αυτό είναι ίσως το πιο ενδιαφέρον από τα παράξενα χαρακτηριστικά των LLM. Στην απλούστερη μορφή τους, τα μοντέλα έχουν την τάση να επινοούν πράγματα. Αυτό μπορεί να προέρχεται από το γεγονός ότι η τυχαιότητα εισάγεται στο μοντέλο κατά την πρόβλεψη του επόμενου συμβόλου. Αν αυτό το τυχαίο σύμβολο οδηγεί το μοντέλο σε ένα παράξενο μονοπάτι ψευδαισθήσεων, ας είναι.

Είχα μια πρόσφατη εμπειρία με αυτό, όταν έλεγξα τις βιογραφικές πληροφορίες για έναν φίλο μου στο Bing. Συγκεκριμένα, ενώ το Bing αναγνώρισε σωστά το άτομο ως τραπεζίτη επενδύσεων που εργάζεται για μια συγκεκριμένη τράπεζα, του απέδωσε εντελώς λανθασμένα συναλλαγές συγχωνεύσεων και εξαγορών που (α) δεν είχε κάνει ποτέ και (β) δεν είχαν συμβεί ποτέ στην πραγματική ζωή. Ωστόσο, το μοντέλο ακουγόταν τόσο σίγουρο που για μια στιγμή σκέφτηκα ότι ίσως η μνήμη μου με πρόδιδε.

Είναι χαζά αλλά μπορούν να είναι χρήσιμα σε ορισμένες περιπτώσεις

Σε αυτό το σημείο, αυτά τα μοντέλα θα αξιολογούνταν στο επίπεδο ενός ασκούμενου στο κολέγιο, ο οποίος απαιτεί σημαντική επίβλεψη και του οποίου το αποτέλεσμα πρέπει να ελέγχεται σε σχέση με το υλικό πηγής. Τούτου λεχθέντος, πολλές εταιρείες χρησιμοποιούν ασκούμενους φοιτητές για διάφορες εργασίες. Συγκεκριμένα, το έχω βρει χρήσιμο όταν πρέπει να συνοψίσω σημαντικές ποσότητες πληροφοριών από διάφορες πηγές ή όταν θα ήθελα ένα γρήγορο σεμινάριο για ένα εντελώς νέο θέμα. Ωστόσο, θα πρέπει πάντα να ελέγχετε τις πληροφορίες της πηγής, αν οι πληροφορίες πρέπει να είναι πραγματικά αξιόπιστες.

Αν βρήκατε κάποια επιπλέον χρήσιμα πράγματα που μπορεί να κάνει το LLM, παρακαλούμε να το δημοσιεύσετε στα σχόλια. Ομοίως, εάν βρήκατε τρόπους να μπερδέψετε τα LLM ή αξιόπιστους τρόπους για να προσδιορίσετε πότε δημιουργήθηκε εύλογα καλά δημιουργημένο περιεχόμενο από ένα LLM.

Αρχικά δημοσιεύθηκε στο Due Diligence and Art

Suggest a correction