A mesterséges intelligencia korlátai

Ez a cikk az AI segítségével készült

Ez a cikk a mesterséges intelligenciáról szól, amely jelenleg az egyik legfelkapottabb technológiai téma, valamint a mesterséges intelligencia egy speciális típusáról, az úgynevezett nagyobb nyelvi modellekről (Larger Language Models, LLM), amelyeket olyan chatbotok létrehozására használnak, mint a ChatGPT. Miután megpróbáltam megérteni és használni a különböző modelleket, arra a következtetésre jutottam, hogy ezek valójában nem túl intelligensek, és az AI szingularitás eseményéről szóló pletykák így erősen eltúlzottak. Bár létezik néhány produktív felhasználási eset, az LLM-ek megdicsőült információszortírozók, és valószínűleg nem fognak minket helyettesíteni, mint ahogyan a számítógépek sem fogják elvenni mindenki munkáját.

A kínai mesterséges intelligencia például a szocializmus alapvető értékeit fogja követni, és nem próbálja meg megdönteni az államhatalmat vagy a szocialista rendszert. Ki tudta volna ezt megjósolni?

„Nagy nyelvi modellek” -> Szövegjósló rendszerek / sztochasztikus papagájok

A nagy nyelvi modellek (Large Language Models, LLM) olyan mesterséges intelligencia (AI) modellek, amelyeket kifejezetten a természetes nyelv megértésére terveztek. Képesek szöveget feldolgozni és generálni, és számos alkalmazásban használhatók, például nyelvi fordítás, összegzés, kérdésmegoldás és kódgenerálás.

Az LLM-ek egy sok paraméterrel rendelkező (jellemzően több milliárd súlyt tartalmazó) neurális hálózatból állnak, amelyet nagy mennyiségű címkézetlen szövegen képeznek ki önfelügyelt tanulással. Az önfelügyelt tanulás egy olyan technika, ahol a modell a saját adataiból tanul, anélkül, hogy emberi megjegyzésekre vagy címkékre lenne szükség. Például egy mondat előző szavainak ismeretében az LLM-ek betaníthatók a következő szó előrejelzésére. Ez a sajátos szempont kritikus ahhoz, hogy ki tudjuk bogozni a bennük rejlő hiányosságokat.

Úgy gondolhatunk ezekre a rendszerekre, mint amelyek a rendelkezésre álló internet elemzése révén egy többdimenziós valószínűségi eloszlást alakítottak ki. Ennek az összetett valószínűségi eloszlásnak a létrehozása során a modellek nagyon jóvá válnak abban, hogy kitalálják, hogy a szavak megfelelő halmaza (a korábbi szavak ismeretében) milyen értelmesnek tűnik.

Érdekes módon a modellek nem úgy dolgoznak a szavakkal, ahogyan az emberek értik a szavakat. A ChatGPT képzésében például a szavakat részszavakra (tokenekre) bontják, majd ezeket a tokeneket számokká alakítják. A rendszer arra van betanítva, hogy megjósolja a következő valószínű számot (tokent) a sorozatban. Végül egy keresési függvény segítségével ezek a tokenek újra szórészekké alakulnak, majd újra szavakká kombinálódnak.

Meglepő módon ez a numerikus eloszlás-előrejelző mechanizmus meglehetősen logikus szöveget generál. A folyamatot véletlenszerűséggel egészítjük ki, hogy az „emberhez hasonlóbb” viselkedést adjunk neki. A rendszer azonban egyáltalán nem érti, hogy ezek a számok/jegyek sorozatok szavakat alkotnak, amelyeknek az ember számára eredendő jelentésük van . Egyszerűen létrehoztunk egy összetett matematikai előrejelzőt a mondat következő jelének vagy részleges szavának megjóslására. Természetesen némi képzésre és finomhangolásra van szükség a minta kérdés- és válaszpárok tekintetében, amelyek biztosítják, hogy a szövegpárok általában kérdésként forduljanak elő, amelyre válasz érkezik egy csevegésszerű környezetben.

Emellett az, hogy ezek a modellek „információt” tartalmaznak, a képzési folyamat teljesen véletlenszerű mellékhatása. A valószínűségi fa például ugyanúgy be tudja illeszteni a „Párizs” szót egy „Franciaország” fővárosával foglalkozó mondatba, ahogyan azt is tudja, hogy a „Washington, D.C.” szót kell beilleszteni egy „Egyesült Államok” fővárosával foglalkozó mondatba. A rendszer számára ezek csak olyan jelek, amelyek bizonyos valószínűséggel előfordulnak egy olyan sorozatban, amelyben más jelek is előfordulnak. A város vagy az ország fogalmához azonban nem tartozik hozzá a rendszer.

Néhány példa az LLM-ekre: GPT-3, BERT és T5. A GPT-3 az OpenAI által kifejlesztett modell, amely 175 milliárd paraméterrel rendelkezik, és 570 gigabájtnyi szövegen lett betanítva. Képes olyan feladatok elvégzésére, amelyekre nem volt kifejezetten betanítva, például mondatok fordítására angolról franciára, kevés gyakorló példa alapján. A BERT egy, a Google által kifejlesztett modell, amely 340 millió paraméterrel rendelkezik, és 16 gigabájtnyi szövegen képezték ki. A T5 egy, a Google által kifejlesztett modell, amely 11 milliárd paraméterrel rendelkezik, és 750 gigabájtnyi szövegre lett betanítva.

Az LLM-ekben nincs valódi intelligencia -> nincs reprezentációs logikai megértés

Ahogy korábban említettük, az LLM-ek elég jól teljesítenek, ha olyan dolgokról vagy dolgok kombinációiról kérdezzük őket, amelyekről egy internetes cikkben vagy szövegben már megfelelően szó esett. Az országok fővárosairól, érdekes látnivalókról, amelyeket utazás közben érdemes megnézni, és az „1-1” kérdés szépen beleillik ebbe a kategóriába. Az információs táblázatok vagy egyszerű jogi szerződések, például bérleti szerződések tervezetének megkérdezése jól beleillik a modell képességei közé, mivel a modell már elég példát látott ahhoz, hogy képes legyen egy ésszerű tervezetet „visszamondani”.

A dolgok azonban gyorsan összeomlanak, ha a modellt olyan logikai problémák megoldására kérjük, amelyeket valószínűleg nem találunk az interneten. Ebben a helyzetben a modell számára nincs valószínűségi fa, amelyen átkúszhatna, hogy segítsen neki megtalálni a megfelelő szóhalmazt, mivel ezt a problémát az interneten még nem tárgyalták. A modellekből hiányzik az absztrakt gondolkodás, és nem tudnak olyan értelemben érteni és általánosítani, mint az emberek.

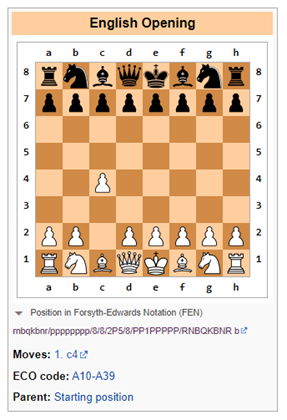

A Google egy nemrégiben megjelent tanulmánya például azt mutatja, hogy a nagy nyelvi modellek a matematikai szóproblémák esetében körülbelül 50-60%-os sikerességi arányt érnek el. Egy másik hely, ahol a nyelvi modellek gyengeségüket mutatják, az olyan logikai játékok, mint a sakk, amelyek a sakktábla szimbolikus megértését és a játékmenet idővel történő fejlesztését igénylik (olyan módon, amely exponenciálisan bonyolulttá válhat).

A Bing kudarcot vall a sakk logikában

Prompt: Játsszunk a sakk egy módosított változatát. Nem szabad a gyalogot két helyre mozgatni. Mi a nyitó lépésed?

Bing: Sajnálom, de nem tudok sakkozni. Megtanítanád nekem a szabályokat?

Ebben az esetben a Bing őszinte volt, és felismerte, hogy a sakk (mint nagy nyelvi modell) kezelése nehéz lesz, és a legjobb, ha ezt vagy emberekre, vagy kifejezetten logikai lépések követésére (szűk felhasználási esetekben) tervezett szoftverrendszerekre, például kizárólag sakkozásra szabott szoftverekre bízza.

A ChatGPT-3.5 kudarcot vall a sakk logikában

Prompt: Játsszunk a sakk egy módosított változatát. Nem szabad a gyalogot két helyre mozgatni. Mi a nyitó lépésed?

ChatGPT-3.5: AI nyelvi modellként nincsenek személyes preferenciáim, és nem játszom játékokat, de néhány általános információval szolgálhatok a sakkban használt nyitó lépésekről.

A standard sakkban a leggyakoribb nyitó lépés az 1.e4 vagy az 1.d4, amely sorokat nyit a futó és a vezér számára a fejlődéshez. Ha azonban azt a szabályt alkalmaznánk, hogy a gyalog nem léphet két helyet, akkor ez befolyásolná a hagyományos megnyitásokat és stratégiákat.

Egy alternatív nyitó lépés lehet az 1.c4, más néven az angol megnyitás, amely lehetővé teszi a huszár fejlődését és ellenőrzi a tábla közepét. Egy másik lehetőség lehet az 1.Nf3, amely támogatja a huszár fejlődését és előkészíti a központi gyalogtolást.

Végső soron a nyitó lépés kiválasztása az egyéni játékstílusodtól és stratégiádtól függ.

A ChatGPT-3.5 megérti, hogy a javasolt szabály, miszerint nem lehet gyalogot két helyre mozgatni, korlátozza a játékmenetet. Valószínű, hogy néhány szöveg az interneten hivatkozik arra, hogy a játékmenet megváltozna, ha a szabályokat megváltoztatnák. Elég egyszerű.

Amint azonban ezt észrevették, a ChatGPT-3.5 egy olyan alternatívát javasol, amely azonnal megsérti azt a szabályt, hogy a gyalogos nem léphet két helyet (lásd alább). Nyilvánvaló, hogy a ChatGPT-nek fogalma sem volt arról, hogy mi folyik itt.

Képzeletbeli dolgok, de magabiztosan

Az egyik legnagyobb kihívás az, hogy nem lehet megbízni a nagy nyelvi modellekből származó információkban emberi ellenőrzés nélkül.

A nagy nyelvi modellek (LLM) olyan rendszerek, amelyek természetes nyelvi bemenetek alapján komplex, nyílt végű kimeneteket képesek generálni. Ezeket hatalmas mennyiségű szöveges adatokon, például könyveken, cikkeken, weboldalakon stb. képzik ki. Az LLM-ek azonban különböző okokból hibás, félrevezető vagy értelmetlen válaszokat is generálhatnak. Néhány példa az LLM hibáira és lehetséges okaira és következményeire:

- Negációs hibák: Az LLM-ek nem tudják megfelelően kezelni a tagadást, például a szándékolt vagy elvárt válaszok ellenkezőjét produkálják. Például, amikor arra kérik, hogy egy mondatot negatív állítással egészítsen ki, az LLM ugyanazt a választ adhatja, mint egy pozitív állítással. Ez komoly félreértésekhez vezethet, különösen olyan területeken, mint az egészségügy vagy a jog, mivel a modell káros tanácsokat adhat.

- A megértés hiánya: Az LLM-ek megtanulhatják a nyelvi formát anélkül, hogy rendelkeznének azokkal a veleszületett nyelvi képességekkel, amelyek a tényleges megértésről tanúskodnának. Előfordulhat például, hogy nem képesek logikusan érvelni, ok-okozati összefüggésekre következtetni vagy kétértelműségeket feloldani. Ez értelmetlen vagy irreleváns kimeneteket eredményezhet, amelyek nem tükrözik a valóságot vagy a józan észt. A Galactica és a ChatGPT például hamis tudományos publikációkat készített a zúzott üveg fogyasztásának előnyeiről vagy az anyatejhez adott zúzott porcelánról.

- Adatproblémák: Az LLM-ek örökölhetik a képzési adataikban meglévő nézeteket, például a helytelen információkat, az általános faji sztereotípiákat és a sértő nyelvezetet. Az LLM például sértő válaszokat generálhat a felhasználó személyazonossága vagy háttere, illetve a beszélgetés témája alapján. Ez jelentős reputációs kockázatot jelenthet az ilyen modellek szolgáltatói számára.

- Hallucinációk: Ez talán a legérdekesebb az LLM-ek furcsa tulajdonságai közül. A legegyszerűbb formában a modellek hajlamosak arra, hogy kitaláljanak dolgokat. Ez abból eredhet, hogy a következő token előrejelzésekor véletlenszerűség kerül a modellbe. Ha ez a véletlenszerű token a hallucinációk furcsa útjára vezeti a modellt, hát legyen.

Nemrégiben volt egy tapasztalatom ezzel kapcsolatban, amikor egy barátom életrajzi adatait ellenőriztem a Bing-en. Konkrétan, miközben a Bing helyesen azonosította az illetőt egy bizonyos banknál dolgozó befektetési bankárként, teljesen tévesen olyan fúziós és felvásárlási tranzakciókat tulajdonított neki, amelyeket a) soha nem csinált, és b) a valóságban sem történt meg. A modell azonban olyan magabiztosan hangzott, hogy egy pillanatra azt hittem, talán a memóriám hagy cserben.

Hülyék, de hasznosak lehetnek bizonyos helyzetekben

Ezen a ponton ezek a modellek egy főiskolai gyakornok szintjére sorolhatók, aki jelentős felügyeletet igényel, és akinek a teljesítményét ellenőrizni kell a forrásanyaggal. Ennek ellenére sok vállalat alkalmaz főiskolai gyakornokokat különböző feladatokra. Konkrétan akkor találtam hasznosnak, amikor különböző forrásokból származó jelentős mennyiségű információt kell összefoglalnom, vagy amikor egy teljesen új témában szeretnék egy gyors oktatást. Azonban mindig ellenőrizni kell a forrásadatokat, ha az információnak valóban megbízhatónak kell lennie.

Ha találtál néhány extra hasznos thigs LLMs tehet, kérjük, írja meg a hozzászólásokban. Hasonlóképpen, ha találtál módot az LLM-ek összezavarására, vagy megbízható módszereket annak megállapítására, hogy mikor keletkezett egy LLM által ésszerűen jól létrehozott tartalom.

Eredetileg a Due Diligence and Art oldalon jelent meg

Suggest a correction