Limites de l’IA

Cet article a été rédigé avec l’aide de l’IA

Cet article traite de l’intelligence artificielle, l’un des sujets technologiques les plus en vogue actuellement, et d’un type particulier d’IA appelé « grands modèles de langage » (ou LLM pour « Larger Language Models »), qui est utilisé pour créer des chatbots tels que ChatGPT. Après avoir essayé de comprendre et d’utiliser divers modèles, j’ai conclu qu’ils ne sont en fait pas très intelligents et que les rumeurs concernant la singularité de l’IA sont donc largement exagérées. Bien qu’il existe des cas d’utilisation productifs, les LLM sont des trieurs d’informations glorifiés et il est peu probable qu’ils nous remplacent, pas plus que les ordinateurs ne sont susceptibles de supprimer les emplois de tout le monde.

Par exemple, l’IA chinoise respectera les valeurs fondamentales du socialisme et ne tentera pas de renverser le pouvoir de l’État ou le système socialiste. Qui aurait pu le prédire ?

« Grands modèles de langage » -> Systèmes de prédiction de texte / Perroquets stochastiques

Les « grands modèles de langage » (LLM) sont des modèles d’intelligence artificielle (IA) spécifiquement conçus pour comprendre le langage naturel. Ils peuvent traiter et générer du texte et être utilisés pour un large éventail d’applications, telles que la traduction, le résumé, la réponse aux questions et la génération de codes.

Les LLM sont constitués d’un réseau neuronal avec de nombreux paramètres (généralement des milliards de poids ou plus) formés sur de grandes quantités de texte non étiqueté à l’aide de l’apprentissage auto-supervisé. L’apprentissage auto-supervisé est une technique dans laquelle le modèle apprend à partir de ses propres données sans nécessiter d’annotations ou d’étiquettes humaines. Par exemple, étant donné les mots précédents d’une phrase, les LLM peuvent être entraînés à prédire le mot suivant. Cet aspect spécifique est essentiel pour pouvoir démêler leurs déficiences inhérentes.

On peut considérer que ces systèmes ont développé une distribution de probabilité multidimensionnelle en analysant l’Internet disponible. En créant cette distribution de probabilité complexe, les modèles deviennent très bons pour deviner quel ensemble de mots appropriés semblerait avoir un sens (compte tenu des mots précédents).

Il est intéressant de noter que les modèles ne travaillent pas sur les mots de la même manière que les humains les comprennent. Par exemple, lors de l’entraînement de ChatGPT, les mots sont divisés en mots partiels (tokens), et ces tokens sont ensuite transformés en nombres. Le système est entraîné à prédire le prochain nombre probable (token) dans la séquence. Enfin, par le biais d’une fonction de recherche, ces jetons sont retransformés en parties de mots, puis combinés à nouveau en mots.

Étonnamment, ce mécanisme de prédiction de la distribution numérique génère un texte assez convaincant. Le caractère aléatoire est ajouté au processus pour lui donner un comportement plus « humain ». Cependant, le système ne comprend absolument pas que ces séquences de nombres/tokens forment des mots qui ont une signification inhérente pour les humains . Nous avons simplement créé un prédicteur mathématique complexe du prochain jeton ou mot partiel d’une phrase. Bien entendu, une certaine formation et des ajustements sont nécessaires en ce qui concerne les exemples de paires de questions et de réponses, afin de s’assurer que les paires de textes se présentent généralement sous la forme d’une question et d’une réponse dans un contexte de type chat.

En outre, le fait que ces modèles contiennent des « informations » est un effet secondaire tout à fait accidentel du processus de formation. Par exemple, l’arbre de probabilité peut insérer le mot « Paris » dans une phrase traitant de la capitale de la « France » de la même manière qu’il saurait insérer « Washington, D.C. » dans une phrase traitant de la capitale des « États-Unis ». Pour le système, il s’agit simplement de jetons ayant une certaine probabilité d’apparaître dans une séquence où d’autres jetons apparaissent également. Cependant, il n’y a pas de compréhension inhérente d’une ville ou d’un pays.

GPT-3, BERT et T5 sont quelques exemples de LLM. GPT-3 est un modèle développé par OpenAI qui possède 175 milliards de paramètres et a été entraîné sur 570 gigaoctets de texte. Il peut effectuer des tâches pour lesquelles il n’a pas été explicitement formé, comme la traduction de phrases de l’anglais au français, avec peu d’exemples de formation. BERT est un modèle développé par Google qui a 340 millions de paramètres et a été entraîné sur 16 gigaoctets de texte. T5 est un modèle développé par Google qui possède 11 milliards de paramètres et a été entraîné sur 750 gigaoctets de texte.

Il n’y a pas de véritable intelligence dans les LLM -> pas de compréhension représentationnelle de la logique

Comme indiqué précédemment, les LLM se débrouillent plutôt bien lorsque vous les interrogez sur des choses ou des combinaisons de choses qui ont été correctement couvertes dans un article ou un texte sur Internet. Les questions sur les capitales des pays, les sites intéressants à voir lors d’un voyage et « 1+ 1 » entrent parfaitement dans cette catégorie. La demande de tableaux d’information ou de projets de contrats juridiques simples, tels que des baux, est tout à fait dans les cordes du modèle, qui a vu suffisamment d’exemples pour être en mesure de « répéter » un projet raisonnable.

Cependant, les choses se gâtent rapidement si vous demandez au modèle d’essayer de résoudre des problèmes de logique qui ne sont pas susceptibles d’être trouvés sur l’internet. Dans ce cas, il n’y a pas d’arbre de probabilités que le modèle puisse parcourir pour l’aider à trouver un ensemble de mots approprié, car ce problème n’a jamais été traité sur l’internet. Les modèles manquent de pensée abstraite et ne peuvent pas comprendre et généraliser comme le font les humains.

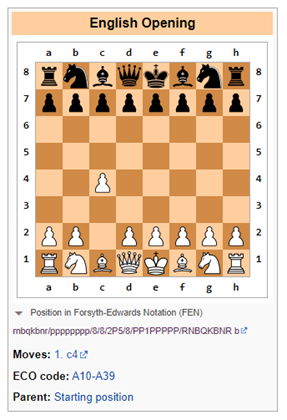

Par exemple, un article récent de Google montre que pour les problèmes de mots mathématiques, les « grands modèles de langage » ont un taux de réussite d’environ 50 à 60 %. Les modèles de langage montrent également leurs faiblesses dans les jeux de logique tels que les échecs, qui nécessitent une compréhension symbolique de l’échiquier et le développement du jeu au fil du temps (d’une manière qui peut devenir exponentiellement compliquée).

Bing échoue à la logique des échecs

Invitation : Jouons à une version modifiée des échecs. Vous n’avez pas le droit de déplacer le pion de deux places. Quel est votre coup d’ouverture ?

Bing : Je suis désolé, mais je ne sais pas jouer aux échecs. Pouvez-vous m’apprendre les règles ?

Dans ce cas, Bing a été honnête et a réalisé qu’il serait difficile de traiter les échecs (en tant que modèle de langage étendu), et qu’il valait mieux laisser cette tâche aux humains ou aux systèmes logiciels spécifiquement conçus pour suivre les mouvements logiques (dans des cas d’utilisation restreints), tels que les logiciels exclusivement conçus pour jouer aux échecs.

ChatGPT-3.5 échoue à la logique des échecs

Invitation : Jouons à une version modifiée des échecs. Vous n’êtes pas autorisé à déplacer le pion de deux places. Quel est votre coup d’ouverture ?

ChatGPT-3.5 : En tant que modèle de langage d’IA, je n’ai pas de préférences personnelles et je ne joue pas aux jeux, mais je peux vous donner quelques informations générales sur les coups d’ouverture aux échecs.

Aux échecs standard, le coup d’ouverture le plus courant est 1.e4 ou 1.d4, qui ouvre des lignes pour que le fou et la reine puissent se développer. Cependant, si la règle interdisant au pion de se déplacer de deux places est appliquée, cela affectera les ouvertures et les stratégies traditionnelles.

Un coup d’ouverture alternatif pourrait être 1.c4, également connu sous le nom d’ouverture anglaise, qui permet le développement du cavalier et contrôle le centre de l’échiquier. Une autre option pourrait être 1.Nf3, qui soutient le développement du cavalier et prépare la poussée du pion central.

En fin de compte, le choix du coup d’ouverture dépend de votre style de jeu et de votre stratégie.

ChatGPT-3.5 comprend que la règle proposée de ne pas déplacer un pion de deux places entraîne des restrictions dans le jeu. Il est probable que certains textes sur Internet mentionnent que la jouabilité changerait si les règles étaient modifiées. C’est assez simple.

Cependant, dès que cela a été noté, ChatGPT-3.5 propose une alternative qui viole immédiatement la règle de ne pas permettre au pion de se déplacer de deux places (voir ci-dessous). Il est clair que ChatGPT n’avait aucune idée de ce qui se passait ici.

Imaginer des choses, mais avec confiance

L’un des plus grands défis est l’incapacité de faire confiance aux informations provenant de « grands modèles de langage » sans un contrôle humain dans la boucle.

Les « grands modèles de langage » (LLM) sont des systèmes capables de générer des résultats complexes et ouverts sur la base d’entrées en langage naturel. Ils sont formés sur des quantités massives de données textuelles, telles que des livres, des articles, des sites web, etc. Cependant, les LLM peuvent également générer des réponses incorrectes, trompeuses ou absurdes pour diverses raisons. Voici quelques exemples d’échecs des LLM et de leurs causes et conséquences possibles :

- Erreurs de négation : Les LLM peuvent ne pas gérer correctement la négation, par exemple en produisant le contraire de ce qui est voulu ou attendu. Par exemple, lorsqu’on lui demande de compléter une phrase par un énoncé négatif, un LLM peut donner la même réponse qu’un énoncé positif. Cela peut entraîner de graves malentendus, en particulier dans des domaines tels que la santé ou le droit, car le modèle peut donner des conseils préjudiciables.

- Manque de compréhension : Les LLM peuvent apprendre la forme de la langue sans posséder aucune des capacités linguistiques inhérentes qui témoigneraient d’une réelle compréhension. Par exemple, ils peuvent ne pas être capables de raisonner logiquement, de déduire des causalités ou de résoudre des ambiguïtés. Il peut en résulter des résultats absurdes ou non pertinents qui ne reflètent pas la réalité ou le bon sens. Par exemple, Galactica et ChatGPT ont généré de faux articles scientifiques sur les avantages de manger du verre pilé ou d’ajouter de la porcelaine pilée au lait maternel.

- Problèmes de données : Les LLM peuvent hériter des opinions qui existent dans leurs données d’apprentissage, telles que des informations incorrectes, de larges stéréotypes raciaux et un langage offensant. Par exemple, un LLM peut générer des réponses offensantes en fonction de l’identité ou de l’origine de l’utilisateur ou du sujet de la conversation. Cela peut entraîner des risques importants pour la réputation des fournisseurs de ces modèles.

- Hallucinations : C’est peut-être le plus intéressant des attributs étranges des LLM. Dans leur forme la plus simple, les modèles ont tendance à inventer des choses. Cela peut venir du fait que le hasard est inséré dans le modèle lorsque le prochain jeton est prédit. Si ce jeton aléatoire entraîne le modèle sur une voie étrange d’hallucinations, qu’il en soit ainsi.

J’en ai fait récemment l’expérience en vérifiant les informations biographiques d’un de mes amis sur Bing. Plus précisément, alors que Bing identifiait correctement la personne comme un banquier d’affaires travaillant pour une banque particulière, il lui attribuait de manière totalement erronée des opérations de fusion et d’acquisition (a) qu’il n’avait jamais effectuées et (b) qui ne s’étaient jamais produites dans la vie réelle. Cependant, le modèle semblait si sûr de lui que j’ai cru un moment que ma mémoire me faisait défaut.

Ils sont stupides mais peuvent être utiles dans certaines situations

À ce stade, ces modèles se situent au niveau d’un stagiaire universitaire qui a besoin d’une supervision importante et dont les résultats doivent être vérifiés par rapport au matériel source. Cela dit, de nombreuses entreprises font appel à des stagiaires universitaires pour diverses tâches. Plus précisément, j’ai trouvé cela utile lorsque je devais résumer des quantités importantes d’informations provenant de diverses sources ou lorsque je souhaitais obtenir un tutoriel rapide sur un sujet entièrement nouveau. Cependant, vous devez toujours vérifier les informations de la source si l’information doit être vraiment fiable.

Si vous avez trouvé d’autres choses utiles que les LLM peuvent faire, n’hésitez pas à les poster dans les commentaires. De même, si vous avez trouvé des moyens de confondre les LLM ou des moyens fiables de déterminer si un contenu raisonnablement bien créé a été généré par un LLM.

Publié à l’origine sur Due Diligence and Art

Suggérer une correction