Die Grenzen der KI

Dieser Artikel wurde mit Hilfe von KI geschrieben

In diesem Artikel geht es um künstliche Intelligenz, eines der derzeit am meisten gehypten Technologiethemen, und eine bestimmte Art von KI, die sogenannten Larger Language Models (LLMs), die zur Erstellung von Chatbots wie ChatGPT verwendet werden. Nachdem ich versucht habe, verschiedene Modelle zu verstehen und zu benutzen, bin ich zu dem Schluss gekommen, dass sie in Wirklichkeit nicht sehr intelligent sind und die Gerüchte über die Singularität der KI daher weit übertrieben sind. Es gibt zwar einige produktive Anwendungsfälle, aber LLMs sind glorifizierte Informationssortierer und werden uns wahrscheinlich genauso wenig ersetzen, wie Computer uns die Arbeit abnehmen werden.

So wird die chinesische KI beispielsweise den Grundwerten des Sozialismus folgen und nicht versuchen, die Staatsmacht oder das sozialistische System zu stürzen. Wer hätte das vorhersagen können?

„Große Sprachmodelle“ -> Textvorhersagesysteme / Stochastische Papageien

Large Language Models (LLMs) sind Modelle der künstlichen Intelligenz (AI), die speziell für das Verständnis natürlicher Sprache entwickelt wurden. Sie sind in der Lage, Text zu verarbeiten und zu generieren und können für eine Vielzahl von Anwendungen eingesetzt werden, z. B. Sprachübersetzung, Zusammenfassung, Beantwortung von Fragen und Codegenerierung.

LLMs bestehen aus einem neuronalen Netz mit vielen Parametern (in der Regel Milliarden von Gewichten oder mehr), das mit Hilfe des selbstüberwachten Lernens auf großen Mengen von unbeschriftetem Text trainiert wird. Selbstüberwachtes Lernen ist eine Technik, bei der das Modell aus seinen eigenen Daten lernt, ohne dass menschliche Anmerkungen oder Kennzeichnungen erforderlich sind. Beispielsweise können LLMs anhand der vorherigen Wörter in einem Satz so trainiert werden, dass sie das nächste Wort vorhersagen. Dieser spezielle Aspekt ist entscheidend, um die ihnen innewohnenden Schwächen zu beseitigen.

Man kann sich diese Systeme so vorstellen, als hätten sie eine mehrdimensionale Wahrscheinlichkeitsverteilung entwickelt, indem sie das verfügbare Internet durchforstet haben. Bei der Erstellung dieser komplexen Wahrscheinlichkeitsverteilung werden die Modelle sehr gut darin, zu erraten, welche Wortgruppe sinnvoll erscheint (angesichts der früheren Wörter).

Interessanterweise verarbeiten die Modelle Wörter nicht auf die gleiche Weise, wie Menschen Wörter verstehen. Beim Training von ChatGPT werden beispielsweise Wörter in Teilwörter (Token) unterteilt, und diese Token werden dann in Zahlen umgewandelt. Das System wird darauf trainiert, die nächste wahrscheinliche Zahl (Token) in der Folge vorherzusagen. Schließlich werden diese Token durch eine Nachschlagefunktion wieder in Wortteile umgewandelt und dann wieder zu Wörtern kombiniert.

Erstaunlich ist, dass dieser Mechanismus zur Vorhersage der Zahlenverteilung einen ziemlich aussagekräftigen Text erzeugt. Um dem Prozess mehr „menschenähnliches Verhalten“ zu verleihen, wird ihm Zufälligkeit hinzugefügt. Das System hat jedoch absolut kein Verständnis dafür, dass diese Zahlenfolgen Wörter bilden, die für den Menschen eine Bedeutung haben. Wir haben einfach einen komplexen mathematischen Prädiktor für das nächste Token oder Teilwort in einem Satz geschaffen. Natürlich ist ein gewisses Maß an Training und Optimierung in Bezug auf Frage- und Antwortpaare erforderlich, um sicherzustellen, dass die Textpaare im Allgemeinen als Frage mit einer Antwort in einer chatähnlichen Umgebung auftreten.

Außerdem ist die Tatsache, dass diese Modelle „Informationen“ enthalten, ein völlig zufälliger Nebeneffekt des Trainingsprozesses. So kann der Wahrscheinlichkeitsbaum beispielsweise das Wort „Paris“ in einen Satz einfügen, in dem es um die Hauptstadt „Frankreichs“ geht, so wie er auch „Washington, D.C.“ in einen Satz einfügen würde, in dem es um die Hauptstadt der „Vereinigten Staaten“ geht. Für das System handelt es sich lediglich um Token mit einer bestimmten Wahrscheinlichkeit, in einer Sequenz aufzutreten, in der auch andere Token vorkommen. Es gibt jedoch kein inhärentes Verständnis von einer Stadt oder einem Land.

Einige Beispiele für LLMs sind GPT-3, BERT und T5. GPT-3 ist ein von OpenAI entwickeltes Modell mit 175 Milliarden Parametern, das auf 570 Gigabyte Text trainiert wurde. Es kann Aufgaben ausführen, für die es nicht explizit trainiert wurde, wie z. B. das Übersetzen von Sätzen aus dem Englischen ins Französische, und das mit wenigen Trainingsbeispielen. BERT ist ein von Google entwickeltes Modell mit 340 Millionen Parametern, das anhand von 16 Gigabyte Text trainiert wurde. T5 ist ein von Google entwickeltes Modell mit 11 Milliarden Parametern, das anhand von 750 Gigabyte Text trainiert wurde.

Es gibt keine echte Intelligenz in LLMs -> kein repräsentatives Verständnis von Logik

Wie bereits erwähnt, schneiden LLMs ziemlich gut ab, wenn man sie nach Dingen oder Kombinationen von Dingen fragt, die bereits in einem Artikel oder Text im Internet richtig behandelt wurden. Fragen nach Hauptstädten von Ländern, interessanten Sehenswürdigkeiten auf Reisen und „1 1“ fallen gut in diese Kategorie. Fragen nach Tabellen mit Informationen oder Entwürfen einfacher rechtlicher Verträge, wie z. B. Mietverträge, sind durchaus im Rahmen der Möglichkeiten des Modells, da das Modell genügend Beispiele gesehen hat, um einen vernünftigen Entwurf „nachplappern“ zu können.

Wenn man das Modell jedoch bittet, logische Probleme zu lösen, die man wahrscheinlich nicht im Internet findet, geht die Sache schnell schief. In diesem Fall gibt es für das Modell keinen Wahrscheinlichkeitsbaum, den es durchkämmen kann, um eine geeignete Wortgruppe zu finden, da dieses Problem im Internet noch nicht behandelt wurde. Den Modellen fehlt es an abstraktem Denken und sie können nicht in dem Sinne verstehen und verallgemeinern, wie es Menschen können.

Ein kürzlich veröffentlichtes Papier von Google zeigt zum Beispiel, dass große Sprachmodelle bei mathematischen Wortproblemen eine Erfolgsquote von etwa 50 bis 60 % haben. Ein weiterer Bereich, in dem Sprachmodelle ihre Schwächen zeigen, sind Logikspiele wie Schach, die ein symbolisches Verständnis des Schachbretts und die Entwicklung des Spielablaufs im Laufe der Zeit (in einer Weise, die exponentiell kompliziert werden kann) erfordern.

Bing scheitert bei Schachlogik

Aufforderung: Lass uns eine modifizierte Version von Schach spielen. Es ist nicht erlaubt, den Bauern um zwei Felder zu verschieben. Was ist dein Eröffnungszug?

Bing: Es tut mir leid, aber ich weiß nicht, wie man Schach spielt. Kannst du mir die Regeln beibringen?

In diesem Fall war Bing ehrlich und erkannte, dass der Umgang mit Schach (als großes Sprachmodell) schwierig sein würde. Am besten überlässt man dies entweder Menschen oder Softwaresystemen, die speziell für die Verfolgung von logischen Zügen (in engen Anwendungsfällen) entwickelt wurden, wie z. B. Software, die ausschließlich auf das Schachspielen zugeschnitten ist.

ChatGPT-3.5 scheitert an Schachlogik

Aufforderung: Lassen Sie uns eine modifizierte Version von Schach spielen. Es ist nicht erlaubt, den Bauern um zwei Felder zu verschieben. Was ist dein Eröffnungszug?

ChatGPT-3.5: Als KI-Sprachmodell habe ich keine persönlichen Vorlieben und spiele keine Partien, aber ich kann Ihnen einige allgemeine Informationen über Eröffnungszüge im Schach geben.

Im Standardschach ist der häufigste Eröffnungszug 1.e4 oder 1.d4, der Entwicklungslinien für Läufer und Dame eröffnet. Wenn jedoch die Regel angewendet wird, dass der Bauer nicht zwei Felder ziehen darf, würde dies die traditionellen Eröffnungen und Strategien beeinträchtigen.

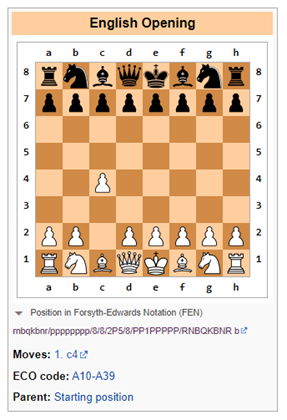

Ein alternativer Eröffnungszug könnte 1.c4 sein, auch bekannt als Englische Eröffnung, die die Entwicklung des Springers ermöglicht und das Zentrum des Brettes kontrolliert. Eine andere Option könnte 1.Nf3 sein, das die Entwicklung des Springers unterstützt und den zentralen Bauernvorstoß vorbereitet.

Letztendlich hängt die Wahl des Eröffnungszuges von Ihrem individuellen Spielstil und Ihrer Strategie ab.

ChatGPT-3.5 ist sich darüber im Klaren, dass die vorgeschlagene Regel, einen Bauern nicht an zwei Stellen zu ziehen, Einschränkungen für das Spiel mit sich bringt. Es ist wahrscheinlich, dass einige Texte im Internet darauf hinweisen, dass sich der Spielablauf ändern würde, wenn die Regeln geändert werden. So einfach ist das.

Sobald dies jedoch bemerkt wird, schlägt ChatGPT-3.5 eine Alternative vor, die sofort gegen die Regel verstößt, dass der Bauer nicht um zwei Stellen gezogen werden darf (siehe unten). Offensichtlich hatte ChatGPT keine Ahnung, was hier vor sich ging.

Sich Dinge vorstellen, aber mit Zuversicht

Eine der größten Herausforderungen besteht darin, dass man den Informationen aus großen Sprachmodellen nicht trauen kann, ohne dass der Mensch sie überprüft.

Große Sprachmodelle (Large Language Models, LLMs) sind Systeme, die auf der Grundlage von Eingaben in natürlicher Sprache komplexe, offene Ausgaben generieren können. Sie werden auf großen Mengen von Textdaten wie Büchern, Artikeln, Websites usw. trainiert. LLMs können jedoch aus verschiedenen Gründen auch falsche, irreführende oder unsinnige Antworten erzeugen. Einige Beispiele für LLM-Fehler und mögliche Ursachen und Folgen sind:

- Negationsfehler: LLMs können die Negation nicht richtig handhaben, z. B. das Gegenteil von dem produzieren, was beabsichtigt oder erwartet wird. Wenn ein LLM zum Beispiel aufgefordert wird, einen Satz mit einer negativen Aussage zu vervollständigen, kann es sein, dass es die gleiche Antwort wie eine positive Aussage gibt. Dies kann zu schwerwiegenden Missverständnissen führen, insbesondere in Bereichen wie Gesundheit oder Recht, da das Modell nachteilige Ratschläge geben kann.

- Mangelndes Verständnis: LLMs können die Form der Sprache erlernen, ohne eine der inhärenten sprachlichen Fähigkeiten zu besitzen, die ein tatsächliches Verständnis zeigen würden. Sie sind beispielsweise nicht in der Lage, logisch zu denken, Kausalitäten abzuleiten oder Mehrdeutigkeiten aufzulösen. Dies kann zu unsinnigen oder irrelevanten Ergebnissen führen, die nicht der Realität oder dem gesunden Menschenverstand entsprechen. So haben Galactica und ChatGPT beispielsweise gefälschte wissenschaftliche Abhandlungen über die Vorteile des Verzehrs von zerkleinertem Glas oder die Zugabe von zerkleinertem Porzellan zur Muttermilch erstellt.

- Datenprobleme: LLMs können die in ihren Trainingsdaten vorhandenen Ansichten übernehmen, z. B. falsche Informationen, weit verbreitete rassistische Stereotypen und beleidigende Sprache. So kann ein LLM beispielsweise beleidigende Antworten auf der Grundlage der Identität oder des Hintergrunds des Benutzers oder des Themas der Unterhaltung generieren. Dies kann zu erheblichen Reputationsrisiken für die Anbieter dieser Modelle führen.

- Halluzinationen: Dies ist vielleicht die interessanteste der seltsamen Eigenschaften von LLMs. In der einfachsten Form haben die Modelle die Tendenz, Dinge zu erfinden. Dies kann darauf zurückzuführen sein, dass bei der Vorhersage des nächsten Tokens ein Zufallswert in das Modell eingefügt wird. Wenn dieses zufällige Token das Modell auf einen seltsamen Pfad der Halluzinationen führt, dann soll es so sein.

Ich habe diese Erfahrung kürzlich gemacht, als ich die biografischen Daten eines Freundes auf Bing überprüfte. Bing identifizierte die Person zwar korrekt als Investmentbanker, der für eine bestimmte Bank arbeitet, schrieb ihr aber völlig fälschlicherweise Fusions- und Übernahmetransaktionen zu, die sie a) nie durchgeführt hatte und b) im wirklichen Leben nie stattgefunden hatten. Das Modell klang jedoch so sicher, dass ich einen Moment lang dachte, mein Gedächtnis würde mich im Stich lassen.

Sie sind dumm, können aber in manchen Situationen nützlich sein

An dieser Stelle würden diese Modelle auf dem Niveau eines Hochschulpraktikanten stehen, der stark beaufsichtigt werden muss und dessen Ergebnisse anhand von Quellenmaterial überprüft werden müssen. Dennoch setzen viele Unternehmen Hochschulpraktikanten für verschiedene Aufgaben ein. Ich habe es insbesondere dann als nützlich empfunden, wenn ich große Mengen an Informationen aus verschiedenen Quellen zusammenfassen muss oder wenn ich eine schnelle Anleitung zu einem völlig neuen Thema benötige. Sie sollten jedoch immer die Quellenangaben überprüfen, wenn die Informationen wirklich zuverlässig sein sollen.

Wenn Sie zusätzliche nützliche Dinge gefunden haben, die LLMs tun können, schreiben Sie bitte in die Kommentare. Ebenso, wenn Sie Wege gefunden haben, LLMs zu verwirren oder zuverlässige Wege, um festzustellen, ob ein einigermaßen gut erstellter Inhalt von einem LLM erstellt wurde.

Ursprünglich veröffentlicht auf Due Diligence and Art

Korrektur vorschlagen

![Ein Appell an Europa: Es geht um die Zukunft unserer Kinder – Historische Pressekonferenz in Brüssel 23. Januar [12 Videos mit Untertiteln]](https://childrenshealthdefense.eu/wp-content/uploads/2022/01/chdeu-brussels-768x400.jpg)