Limiti dell’IA

Questo articolo è stato redatto con l’aiuto dell‘IA

Questo articolo tratta di Intelligenza Artificiale, uno degli argomenti tecnologici più pubblicizzati del momento e nello specifico di un tipo di AI chiamato Larger Language Models (LLMs), utilizzato per creare chatbot quali ChatGPT. Dopo aver cercato di capire e utilizzare diversi modelli, sono giunta alla conclusione che in realtà questi modelli non sono particolarmente intelligenti, pertanto ciò che si dice in merito alla singolarità dell’IA suona alquanto esagerato. Sebbene esistano esempi d’uso riusciti, gli LLM sono classificatori di informazioni sopravvalutati ed è improbabile che ci sostituiscano, così come è improbabile che i computer possano togliere il lavoro a tutti.

Ad esempio, l’IA cinese abbraccerà i valori fondamentali del socialismo e non tenterà di rovesciare il potere statale o il sistema socialista. Chi l’avrebbe mai immaginato?

“Modelli linguistici di grandi dimensioni” -> Sistemi di predizione del testo / Pappagalli stocastici

I modelli linguistici di grandi dimensioni (LLM) sono modelli di intelligenza artificiale (AI) progettati specificamente per comprendere il linguaggio naturale. Sono in grado di elaborare e generare testi e possono essere utilizzati per un’ampia gamma di applicazioni, fra cui traduzioni, riassunti, risposte a domande e generazione di codici.

Gli LLM sono reti neurali di molti (miliardi e più) parametri, che vengono addestrati su un’immensa quantità di testi non etichettatati attraverso la tecnica del self-supervised learning. Con questa tecnica, il modello apprende dai propri dati senza l’intervento di un essere umano e senza etichettature. Ad esempio, in una frase gli LLM possono essere addestrati a predire la parola successiva basandosi sulle parole precedenti. Questa specifica caratterstica è fondamentale per smascherare le loro carenze intrinseche.

Questi sistemi possono essere visti come un qualcosa che ha creato una distribuzione mutidimensionale di probabilità basandosi sull’ analisi di quanto disponibile su Internet. Nel creare questa complessa distribuzione di probabilità, i modelli diventano molto bravi a indovinare quale potrebbe essere un insieme di parole che possa avere un senso (basandosi sulle parole precedenti).

È interessante notare che i modelli non lavorano sulle parole così come le intendono gli umani. Per esempio, nell’addestramento di ChatGPT, le parole vengono suddivise in parole parziali (token), che vengono successivamente trasformate in numeri. Il sistema viene addestrato a prevedere il probabile token successivo da inserire nella sequenza. Attraverso una funzione di ricerca, questi token sono poi nuovamente trasformati in parti di una parola e successivamente ricombinati in parole.

Sorprendentemente, questo meccanismo di predizione della distribuzione numerica genera un testo abbastanza convincente. Per assumere un comportamento più simile a quello umano, al processo viene aggiunta una variabile causale. Il sistema non arriva però assolutamente a capire che queste sequenze di numeri/token formano parole che per gli esseri umani hanno senso compiuto.Abbiamo semplicemente creato un complesso predittore matematico del token o della parola parziale successivi in una frase. Servono naturalmente un addestramento e una ricalibrazione delle coppie di domande e risposte campione, per fare in modo che le combinazioni di testi avvengano sotto forma di domanda e risposta, così come succede in una chat.

Oltre a ciò, il fatto che questi modelli contengano “informazioni” è un effetto del tutto accidentale del processo di addestramento. Per esempio, il diagramma ad albero può inserire la parola ‘Parigi’ in una frase che riguarda la capitale della ‘Francia’, così come inserirebbe ‘Washington, D.C.’ in una frase riguadante la capitale degli ‘Stati Uniti’. Per il sistema, si tratta soltanto di token che hanno una certa probabilità di comparire in una sequenza in cui sono presenti anche altri token. Non c’è però alcuna conoscenza intrinseca di una città o di un paese

GPT-3, BERT e T5 sono alcuni esempi di LLM . GPT-3 è un modello sviluppato da OpenAI, con una capacità di 175 miliardi di parametri e addestrato su un database di 570 gigabyte di dati testuali. È in grado di eseguire compiti per i quali non è stato addestrato esplicitamente, come la traduzione di frasi dall’inglese al francese, con un addestramento che si limita a pochi esempi. BERT è un modello sviluppato da Google, con una capacità di 340 milioni di parametri e addestrato su un database di 16 gigabyte di dati testuali. T5 è un modello sviluppato da Google, con una capacità 11 miliardi di parametri e addestrato su un database di 750 gigabyte di dati testuali.

Non c’è vera intelligenza negli LLM -> Non c’è una vera comprensione della logica

Come già osservato in precedenza, gli LLM se la cavano piuttosto bene quando chiediamo loro cose o combinazioni di cose che sono state opportunamente trattate in un articolo o in un testo apparsi su Internet. Le domande sulle capitali dei vari paesi, sulle mete interessanti da vedere durante un viaggio e su “1 + 1” rientrano perfettamente in questa categoria. La richiesta di tabelle di dati o di bozze di semplici contratti legali, quali ad esempio contratti di locazione, rientra nella gamma di capacità del modello, dato che ha visto abbastanza esempi da poter produrre, “ripetendo a pappagallo”, una bozza ragionevole.

Tuttavia, le cose cambiano radicalmente se si chiede al modello di tentare di risolvere problemi logici, difficilmente presenti su Internet. In questo caso, non essendo il problema ancora stato trattato su Internet, non c’è un diagramma ad albero a cui il modello può ricorrere per trovare un insieme di parole adeguato. I modelli non hanno un pensiero astratto e non possiedono la capacità di comprensione e generalizzzione degli esseri umani.

Ad esempio, un recente articolo apparso su Google riporta che per quanto riguarda i problemi di matematica, i modelli linguistici di grandi dimensioni hanno un tasso di successo di circa il 50%-60%. Un altro ambito in cui i modelli linguistici mostrano le loro debolezze è quello dei giochi di logica come gli scacchi, che richiedono una comprensione simbolica della scacchiera e di come il gioco si sviluppa nel tempo (in modi che possono diventare sempre più complicati).

Bing fallisce nella logica degli scacchi

Prompt: Giochiamo a una versione modificata degli scacchi. Non è consentito muovere il pedone di due posizioni. Qual è la tua mossa di apertura?

Bing: Mi dispiace, ma non so giocare a scacchi. Puoi insegnarmi le regole?

In questo caso, Bing è stato onesto e si è reso conto che (essendo un modello linguistico di grandi dimensioni) sarebbe stato dfficile giocare a scacchi e sarebbe stato meglio lasciarlo fare agli esseri umani o a sistemi software progettati specificamente per monitorare mosse logiche (in casi di utilizzo limitati), ad esempio a un software appositamente creato per il gioco degli scacchi.

ChatGPT-3.5 fallisce con la logica degli scacchi

Prompt: Giochiamo a una versione modificata degli scacchi. Non è consentito muovere il pedone di due posizioni. Qual è la tua mossa di apertura?

ChatGPT-3.5: Come modello linguistico di Intelligenza Artificiale, non ho preferenze personali e non mi dedico ai giochi, ma posso fornirti alcune informazioni generali sulle mosse di apertura negli scacchi.

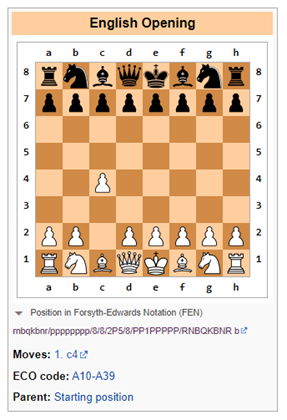

Negli scacchi, le mosse di apertura più comuni sono 1.e4 o 1.d4, che aprono le linee della regina e dell’alfiere. Tuttavia, l’applicazione della regola che non consente al pedone di spostarsi di due posizioni condizionerà le aperture e le strategie tradizionali .

Una mossa di apertura alternativa potrebbe essere 1.c4, nota anche come partita inglese, che permette il naturale sviluppo del cavallo per controllare il centro della scacchiera. Un’altra opzione potrebbe essere l’apertura 1.Nf3, che supporta lo sviluppo del cavallo e prepara la spinta del pedone centrale.

In definitiva, la scelta della mossa di apertura dipende dal tuo stile di gioco e dalla tua strategia individuale.

ChatGPT-3.5 si rende conto che la regola proposta di non muovere un pedone di due posizioni impone delle limitazioni al gioco. È probabile che alcuni testi su Internet facciano riferimento al fatto che modificando le regole, il gioco cambierebbe – il che è facilmente comprensibile.

Tuttavia, non appena la cosa viene rilevata, ChatGPT-3.5 propone un’alternativa che viola immediatamente la regola di non consentire al pedone di spostarsi di due posizioni (vedi sotto). E’ quindi evidente che ChatGPT non idea di cosa stava succedendo.

Traduzione immagine precedente:

Apertura inglese

Posizione nella Forsyth- Edwards Notation (FEN)

Mosse: 1 c4

Codice ECO: A10-A39

Situazione: posizione iniziale

Immaginare le cose, ma con certezza

Una delle sfide più grandi è l’impossibilità di fidarsi delle informazioni che ci forniscono i modelli linguistici di grandi dimensioni, senza un controllo basato sull’approccio human-in-the-loop.

I modelli linguistici di grandi dimensioni (LLM) sono sistemi in grado di generare risultati complessi e aperti, basandosi su input del linguaggio naturale. Vengono addestrati su grandi quantità di dati testuali, fra cui libri, articoli, siti web, ecc. Tuttavia, per tutta una serie di motivi, gli LLM possono anche dare risposte errate, fuorvianti o prive di senso. Ecco alcuni esempi di errori degli LLM e le possibili cause e conseguenze:

- Errori nelle frasi con negazione: può succedere che gli LLM non siano in grado di usare correttamente la negazione e quindi ci dicano l’opposto di ciò che si intende o che ci si aspetta. Ad esempio, quando gli viene chiesto di completare una frase con un’affermazione negativa, un LLM può riprodurre la stessa frase ma con un’affermazione positiva. Ciò può generare gravi malintesi, soprattutto in ambiti come la salute o il diritto, perché il modello può dare consigli pericolosi.

- Mancanza di comprensione: gli LLM possono imparare la forma del linguaggio senza possedere quelle capacità linguistiche necessarie a dimostrare che ci sia effettiva comprensione. Ad esempio, potrebbero non essere in grado di ragionare in modo logico, dedurre la causalità o risolvere l’ambiguità. Ciò può generare risultati improbabili o irrilevanti, avulsi dalla realtà e privi di buon senso. Galactica e ChatGPT hanno generato falsi documenti scientifici sui benefici dati dal mangiare frammenti di vetro frantumato o dall’aggiungere frammenti di porcellana al latte materno.

- Problemi di dati: gli LLM possono far proprie opinioni presenti nei dati utilizzati per il loro addestramento, fra cui informazioni errate, stereotipi razziali e linguaggio offensivo. Ad esempio, un LLM può generare risposte offensive basate sull’identità o il background dell’utente o sull’argomento della conversazione. Ciò può mettere gravemente a rischio la reputazione dei provider di questi modelli.

- Allucinazioni: Questa è forse la stranezza più interessante degli LLM. Nella loro forma più semplice, i modelli tendono a inventare le cose. Ciò può essere dovuto al fatto che si inserisce la casualità per prevedere il token successivo. Se poi questo token generato casualmente conduce il modello su uno strano percorso di allucinazioni, pazienza.

Recentemente ho avuto un’esperienza di questo tipo mentre controllavo la biografia di un mio amico su Bing. Pur avendo correttamente identificato la persona come banchiere d’investimento che lavorava per una determinata banca, Bing gli aveva attribuito in modo del tutto errato operazioni di fusione e acquisizione che (a) non aveva mai fatto e (b) non erano mai avvenute nella realtà. Il modello sembrava però così sicuro che per un attimo ho pensato che forse era la mia memoria che mi stava tradendo .

Sono stupidi ma in alcune circostanze possono essere utili

A questo punto, questi modelli si collocherebbero sullo stesso piano di uno stagista universitario, per il quale si richiede un’attenta supervisione e i cui risultati vanno confrontati con le fonti. Detto questo, sono parecchie le aziende che utilizzano stagisti universitari per varie mansioni. Personalmente trovo utili questi modelli quando devo sintetizzare quantità significative di informazioni provenienti da varie fonti o quando desidero un rapido tutorial su un argomento completamente nuovo. Affinché le informazioni siano davvero affidabili, occorre però verificarne sempre le fonti.

Se avete riscontrato altre cose utili che possono fare gli LLM, indicatele nei commenti. Potete fare lo stesso se avete trovato sistemi per confondere gli LLM o modi sicuri per determinare che un contenuto creato abbastanza bene è stato generato da un LLM.

Articolo originale su Due Diligence and Art

Suggerisci una correzione