As limitações da IA

Este artigo foi escrito com a ajuda da IA

Este artigo é sobre a Inteligência Artificial, um dos tópicos tecnológicos mais discutidos neste momento, nomeadamente um tipo específico de IA chamado Modelos de Linguagem Maior (LLMs), que são usados para criar chatbots como o ChatGPT. Depois de tentar compreender e utilizar vários modelos, concluí que, de facto, não são muito inteligentes e que os rumores sobre o evento da singularidade da IA são, portanto, muito exagerados. Embora existam alguns casos em que podem ser utilizados de forma produtiva, os LLM são apenas classificadores de informação glorificados e não é provável que nos substituam, tal como não é provável que os computadores venham a tirar os empregos a toda a gente.

Por exemplo, a IA chinesa seguirá os valores fundamentais do socialismo e não tentará derrubar o poder do Estado ou o sistema socialista. Quem poderia ter previsto isto?

“Modelos linguísticos de grande dimensão” -> Sistemas de previsão de texto / Papagaios estocásticos

Os modelos de linguagem de grande dimensão (LLM) são modelos de inteligência artificial (IA) especificamente concebidos para compreender a linguagem natural. Podem processar e gerar texto e podem ser utilizados para uma vasta gama de aplicações, como a tradução de línguas, o resumo, a resposta a perguntas e a geração de códigos.

As LLM consistem numa rede neural com muitos parâmetros (normalmente milhares de milhões de pesos ou mais) treinada em grandes quantidades de texto não rotulado, utilizando a aprendizagem auto-supervisionada. A aprendizagem auto-supervisionada é uma técnica em que o modelo aprende a partir dos seus próprios dados sem necessitar de anotações ou etiquetas humanas. Por exemplo, dadas as palavras anteriores de uma frase, os LLM podem ser treinados para prever a palavra seguinte. Este aspeto específico é fundamental para se poderem identificar as suas deficiências inerentes.

Podemos pensar nestes sistemas como tendo desenvolvido uma distribuição de probabilidades multidimensional através da análise da Internet disponível. Ao criar esta complexa distribuição de probabilidades, os modelos tornam-se muito bons a adivinhar qual o conjunto de palavras que parece fazer sentido (tendo em conta as palavras anteriores).

Curiosamente, os modelos não trabalham com palavras da mesma forma que os humanos as entendem. Por exemplo, no treino do ChatGPT, as palavras são divididas em palavras parciais (tokens), e estes tokens são depois transformados em números. O sistema é treinado para prever o próximo número provável (token) na sequência. Finalmente, através de uma função de pesquisa, estes tokens são transformados novamente em partes de palavras e depois combinados novamente em palavras.

Surpreendentemente, este mecanismo de previsão de distribuição numérica gera um texto bastante convincente. A aleatoriedade é adicionada ao processo para lhe dar um comportamento mais “semelhante ao humano”. No entanto, o sistema não compreende de todo que estas sequências de números/tokes formam palavras que têm um significado inerente para os humanos. Simplesmente criámos um preditor matemático complexo do próximo token ou palavra parcial de uma frase. É claro que é necessário algum treino e afinação relativamente a exemplos de pares de perguntas e respostas que garantam que os pares de texto ocorrem geralmente como uma pergunta com uma resposta num ambiente de conversação.

Além disso, o facto de estes modelos conterem “informação” é um efeito secundário totalmente acidental do processo de treino. Por exemplo, a árvore de probabilidades pode inserir a palavra “Paris” numa frase que trate da capital de “França” da mesma forma que saberia inserir “Washington, D.C.” numa frase que trate da capital dos “Estados Unidos”. Para o sistema, trata-se apenas de símbolos com uma certa probabilidade de aparecerem numa sequência em que outros símbolos também ocorrem. No entanto, não existe uma compreensão inerente de uma cidade ou de um país.

Alguns exemplos de LLMs são o GPT-3, o BERT e o T5. O GPT-3 é um modelo desenvolvido pela OpenAI que tem 175 mil milhões de parâmetros e foi treinado com 570 gigabytes de texto. Pode executar tarefas para as quais não foi explicitamente treinado, como traduzir frases de inglês para francês, com poucos exemplos de treino. O BERT é um modelo desenvolvido pela Google que tem 340 milhões de parâmetros e foi treinado com 16 gigabytes de texto. O T5 é um modelo desenvolvido pela Google que tem 11 mil milhões de parâmetros e foi treinado com 750 gigabytes de texto.

Não há inteligência real nos LLMs -> Não há compreensão representacional da lógica

Como já foi referido, os LLMs saem-se bastante bem quando lhes perguntamos sobre coisas ou combinações de coisas que já foram devidamente abordadas num artigo ou texto na Internet. As perguntas sobre capitais de países, pontos turísticos interessantes para ver quando se viaja e “1+1” enquadram-se bem nesta categoria. Pedir tabelas de informação ou minutas de contratos legais simples, como contratos de arrendamento, está bem dentro do conjunto de capacidades do modelo, uma vez que o modelo já viu exemplos suficientes para ser capaz de “papaguear” uma minuta razoável.

No entanto, as coisas desmoronam-se rapidamente se pedirmos ao modelo que tente resolver problemas de lógica que dificilmente se encontram na Internet. Nesta situação, não existe uma árvore de probabilidades que o modelo possa explorar para o ajudar a encontrar um conjunto de palavras adequado, porque este problema nunca foi abordado na Internet. Os modelos não têm pensamento abstrato e não conseguem compreender e generalizar no mesmo sentido em que os humanos são capazes de generalizar.

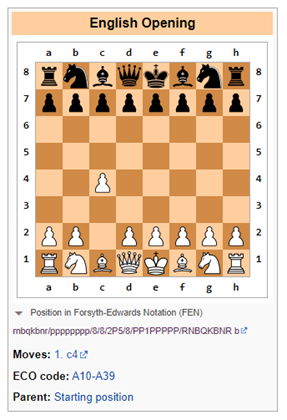

Por exemplo, um artigo recente da Google mostra que, para problemas de palavras matemáticas, os modelos de linguagem de grande dimensão têm uma taxa de sucesso de cerca de 50% a 60%. Outra área onde os modelos de linguagem mostram as suas fraquezas é nos jogos de lógica como o xadrez, que requerem uma compreensão simbólica do tabuleiro de xadrez e o desenvolvimento da jogabilidade ao longo do tempo (de formas que podem tornar-se exponencialmente complicadas).

Bing falha na lógica do xadrez

Sugestão: Vamos jogar uma versão modificada do xadrez. Não é permitido mover o peão duas casas. Qual é a tua jogada de abertura?

Bing: Desculpa, mas não sei jogar xadrez. Podes ensinar-me as regras?

Neste caso, o Bing foi honesto e apercebeu-se que lidar com o xadrez (como um Modelo de Linguagem Grande) ia ser difícil, sendo melhor deixá-lo para os humanos ou para sistemas de software especificamente concebidos para seguir movimentos lógicos (em casos de utilização restrita), como software exclusivamente concebido para jogar xadrez.

ChatGPT-3.5 falha na lógica do xadrez

Prompt: Vamos jogar uma versão modificada de xadrez. Não é permitido mover o peão duas casas. Qual é a tua jogada de abertura?

ChatGPT-3.5: Como modelo de linguagem de IA, não tenho preferências pessoais nem jogo jogos, mas posso dar-te algumas informações gerais sobre jogadas de abertura no xadrez.

No xadrez normal, a jogada de abertura mais comum é 1.e4 ou 1.d4, que abre linhas para o bispo e a rainha se desenvolverem. No entanto, se a regra de não permitir que o peão se mova duas casas for aplicada, isso afetaria as aberturas e estratégias tradicionais.

Uma jogada de abertura alternativa poderia ser 1.c4, também conhecida como a Abertura Inglesa, que permite o desenvolvimento do cavalo e controla o centro do tabuleiro. Outra opção poderia ser 1.Nf3, que apoia o desenvolvimento do cavalo e prepara o avanço do peão central.

Em última análise, a escolha da jogada de abertura depende do seu estilo de jogo e estratégia individual.

O ChatGPT-3.5 compreende que a regra proposta de não mover um peão a duas casas implica restrições na jogabilidade. É provável que algum texto na Internet refira que a jogabilidade mudaria se as regras fossem alteradas. É muito simples.

No entanto, assim que isso é registado, o ChatGPT-3.5 propõe uma alternativa que viola imediatamente a regra de não permitir que o peão se mova duas casas (ver abaixo). Claramente, o ChatGPT não fazia ideia do que se estava a passar aqui.

Imaginar coisas, mas com confiança

Um dos maiores desafios é a incapacidade de confiar na informação de grandes modelos de linguagem sem uma revisão humana.

Os modelos de linguagem de grande dimensão (LLM) são sistemas que podem gerar resultados complexos e abertos com base em entradas de linguagem natural. São treinados com base em grandes quantidades de dados de texto, tais como livros, artigos, sítios Web, etc. No entanto, os LLMs também podem gerar respostas incorretas, enganosas ou sem sentido por várias razões. Alguns exemplos de falhas de LLM e possíveis causas e consequências são:

- Erros de negação: Os LLMs podem não tratar corretamente a negação, produzindo o oposto do que se pretende ou espera. Por exemplo, quando lhes é pedido que completem uma frase com uma afirmação negativa, um LLM pode dar a mesma resposta que uma afirmação positiva. Isto pode levar a graves mal-entendidos, especialmente em domínios como a saúde ou o direito, uma vez que o modelo pode dar conselhos prejudiciais.

- Falta de compreensão: Os LLMs podem aprender a forma da língua sem possuir nenhuma das capacidades linguísticas inerentes que demonstrariam uma compreensão efetiva. Por exemplo, podem não ser capazes de raciocinar logicamente, inferir causalidade ou resolver ambiguidades. Isto pode dar origem a resultados sem sentido ou irrelevantes, que não refletem a realidade ou o senso comum. Por exemplo, o Galactica e o ChatGPT geraram artigos científicos falsos sobre os benefícios de comer vidro esmagado ou de adicionar porcelana esmagada ao leite materno.

- Problemas com os dados: Os LLMs podem herdar as opiniões que existem nos seus dados de treino, tais como informações incorretas, estereótipos raciais generalizados e linguagem ofensiva. Por exemplo, um LLM pode gerar respostas ofensivas com base na identidade ou origem do utilizador ou no tópico da conversa. Este facto pode criar riscos significativos para a reputação dos fornecedores destes modelos.

- Alucinações: Este é talvez o mais interessante dos estranhos atributos dos LLMs. Na sua forma mais simples, os modelos têm tendência para inventar coisas. Isto pode dever-se ao facto de a aleatoriedade ser inserida no modelo quando se prevê o token sucessivo. Se este símbolo aleatório levar o modelo por um caminho estranho de alucinações, que assim seja.

Tive uma experiência recente com isto quando estava a verificar a informação biográfica de um amigo meu no Bing. Especificamente, embora o Bing identificasse corretamente o indivíduo como um banqueiro de investimentos que trabalhava para um determinado banco, atribuiu-lhe, de forma totalmente incorreta, transações de fusões e aquisições que (a) ele nunca tinha feito e (b) nunca tinham ocorrido na vida real. No entanto, o modelo parecia tão confiante que, por momentos, julguei que a minha memória pudesse estar a falhar.

São estúpidos, mas podem ser úteis em algumas situações

Atualmente, estes modelos estão ao nível de um estagiário universitário que requer uma supervisão significativa e cujos resultados têm de ser verificados com base no material de origem. Dito isto, muitas empresas utilizam estagiários universitários para várias tarefas. Especificamente, considero-o útil quando é preciso de resumir quantidades significativas de informação de várias fontes ou quando quero um tutorial rápido sobre um assunto completamente novo. No entanto, devemos sempre verificar a informação fonte se a informação veiculada tiver que ser absolutamente fidedigna.

Se tiver conhecimento de outras coisas úteis que os LLMs podem fazer, por favor mencione-o nos comentários. Escreva também no caso de ter encontrado maneiras de confundir os LLMs ou formas fiáveis de identificar se um conteúdo razoavelmente bem criado foi ou não gerado por um LLM.

Originalmente publicado em Due Diligence and Art

Suggest a correction