Ограниченията на Изкуствения Интелект

Тази статия е написана с помощта на ИИ

Тази статия е посветена на изкуствения интелект, една от най-актуалните технологични теми в момента, както и на специфичен вид Изкуствен Интелект (ИИ), наречен Large Language Models (LLMs) (Големи езикови модели – ГЕМ), който се използва за създаване на чатботове като ChatGPT. След като се опитах да разбера и да използвам различни модели, стигнах до заключението, че всъщност те не са много интелигентни и поради това слуховете за събитието сингулярност на ИИ са силно преувеличени. Въпреки че съществуват някои продуктивни случаи на употреба, големите езикови модели са прославени сортировачи на информация и е малко вероятно да ни заменят, както е малко вероятно компютрите да отнемат работата на всички.

Например китайският изкуствен интелект ще бъде следващ основните ценности на социализма и няма да се опитва да срине държавната власт или социалистическата система. Кой би могъл да предвиди това?

„Големи езикови модели“ -> Системи за предсказване на текст / Стохастични папагали

Големите езикови модели (ГЕМ) са модели на изкуствения интелект (ИИ), специално разработени за разбиране на естествения език. Те могат да обработват и генерират текст и могат да се използват за широк спектър от приложения, като например езиков превод, обобщаване, отговаряне на въпроси и генериране на кодове.

Големите езикови модели се състоят от невронна мрежа с много параметри (обикновено милиарди тегла или повече), обучена върху големи количества немаркиран текст чрез самоконтролирано обучение. Самоконтролираното обучение е техника, при която моделът се учи от собствените си данни, без да изисква човешки анотации или етикети. Например, като се имат предвид предишните думи в едно изречение, големите езикови модели могат да бъдат обучени да предсказват следващата дума. Този специфичен аспект е от решаващо значение, за да може да се отстранят присъщите им недостатъци.

Можете да мислите за тези системи като за такива, които са разработили многомерно разпределение на вероятностите чрез анализ на наличния интернет. Създавайки това сложно вероятностно разпределение, моделите стават много добри в отгатването на това какъв подходящ набор от думи би изглеждал смислен (предвид предишните думи).

Интересно е, че моделите не работят с думите по същия начин, по който хората разбират думите. Например при обучението на ChatGPT думите се разделят на частични думи (токени), а след това тези токени се превръщат в числа. Системата се обучава да предсказва следващото вероятно число (токен) в поредицата. Накрая, чрез функция за търсене, тези токени се превръщат обратно в части от думи и след това се комбинират отново в думи.

Удивително е, че този механизъм за предсказване на цифрово разпределение генерира доста смислен текст. Към процеса е добавена случайност, за да му се придаде по-„човешко поведение“. Системата обаче няма абсолютно никакво разбиране, че тези последователности от числа/точки образуват думи, които имат присъщо значение за хората. Ние просто сме създали сложен математически предсказател на следващата символична или частична дума в изречението. Разбира се, необходимо е известно обучение и настройка по отношение на примерните двойки въпроси и отговори, които да гарантират, че двойките текст обикновено се появяват като въпрос с отговор към него в обстановка, подобна на чат.

Освен това фактът, че тези модели съдържат „информация“, е напълно случаен страничен ефект от процеса на обучение. Например дървото на вероятностите може да вмъкне думата „Париж“ в изречение, отнасящо се до столицата на „Франция“, по същия начин, по който би знаело да вмъкне „Вашингтон, окръг Колумбия“ за изречение, отнасящо се до столицата на „Съединените щати“. За системата това са просто лексеми с определена вероятност да се появят в последователност, в която се появяват и други лексеми. Въпреки това, няма присъщо разбиране за град или държава.

Някои примери за големи езикови модели са GPT-3, BERT и T5. GPT-3 е модел, разработен от OpenAI, който има 175 милиарда параметъра и е обучен върху 570 гигабайта текст. Той може да изпълнява задачи, за които не е бил изрично обучен, като например да превежда изречения от английски на френски език, с малко примери за обучение. BERT е модел, разработен от Google, който има 340 милиона параметъра и е обучен на 16 гигабайта текст. T5 е модел, разработен от Google, който има 11 милиарда параметъра и е обучен върху 750 гигабайта текст.

В големите езикови модели няма истинска интелигентност -> няма репрезентативно разбиране на логиката

Както беше отбелязано по-рано, големите езикови модели се справят доста добре, когато ги питате за неща или комбинации от неща, които са били надлежно разгледани в статия или текст в интернет. Питането за столици на държави, интересни забележителности, които да видите, когато пътувате, и „1+1“ попадат в тази категория. Задаването на въпроси за таблици с информация или проекти на прости правни договори, като например договори за лизинг, са в рамките на възможностите на модела, тъй като той е видял достатъчно примери, за да може да „папагалства“ за разумен проект.

Нещата обаче бързо се развалят, ако поискате от модела да се опита да реши логически задачи, които е малко вероятно да бъдат намерени в интернет. В тази ситуация моделът няма дърво на вероятностите, което да обхожда, за да му помогне да намери подходящ набор от думи, тъй като този проблем не е бил разглеждан в интернет преди. На моделите им липсва абстрактно мислене и не могат да разбират и обобщават в същия смисъл, в който хората на са в състояние да обобщават.

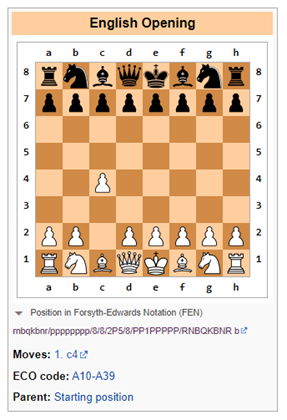

Например неотдавнашен документ на Google показва, че за математически текстови задачи големите езикови модели имат успеваемост от около 50 % до 60 %. Друго място, където езиковите модели показват своите слабости, са логическите игри като шахмат, които изискват символично разбиране на шахматната дъска и развитие на играта с течение на времето (по начини, които могат да станат експоненциално сложни).

Bing се проваля в логиката на шаха

Подкана: Нека да играем модифицирана версия на шахмат. Не ви е позволено да преместите пешката на две места. Какъв е началният ви ход?

Бинг: Съжалявам, но не знам как се играе шах. Можете ли да ме научите на правилата?

В този случай Bing е бил честен и е осъзнал, че справянето с шаха (като голям езиков модел) ще бъде трудно и най-добре е да го остави на хората или на софтуерни системи, специално предназначени за проследяване на логически ходове (в тесни случаи на употреба), като например софтуер, пригоден изключително за игра на шах.

ChatGPT-3.5 се проваля в логиката на шаха

Подкана: Нека да играем модифицирана версия на шахмат. Не ви е позволено да преместите пешката на две места. Какъв е началният ви ход?

ChatGPT-3.5: Като езиков модел на изкуствен интелект аз нямам лични предпочитания и не играя игри, но мога да ви предоставя обща информация за началните ходове в шаха.

В стандартния шахмат най-често срещаният начален ход е 1.e4 или 1.d4, който отваря линии за развитие на епископа и царицата. Ако обаче се приложи правилото за недопускане на преместване на пешката на две места, това би повлияло на традиционните дебюти и стратегии.

Един алтернативен начален ход би могъл да бъде 1.c4, известен още като английския начален ход, който позволява развитието на коня и контролира центъра на дъската. Друг вариант би могъл да бъде 1.Nf3, който подпомага развитието на коня и подготвя изтласкването на пешка в централната част на дъската.

В крайна сметка изборът на начален ход зависи от вашия индивидуален стил на игра и стратегия.

ChatGPT-3.5 разбира, че предложеното правило да не се премества пешка на две места води до ограничения в играта. Вероятно е някои текстове в интернет да споменават, че геймплеят ще се промени, ако правилата бъдат променени. Достатъчно просто.

Въпреки това, веднага след като това бъде отбелязано, ChatGPT-3.5 предлага алтернатива, която незабавно нарушава правилото за недопускане на преместване на пешката на две места (вж. по-долу). Очевидно ChatGPT не е имал представа какво се случва тук.

Представяме си нещата, но уверено

Едно от най-големите предизвикателства е невъзможността да се доверим на информацията от големите езикови модели без преглед от страна на човека в цикъла.

Големите езикови модели са системи, които могат да генерират сложни, отворени резултати въз основа на входни данни от естествен език. Те се обучават върху огромни количества текстови данни, като книги, статии, уебсайтове и др. Въпреки това големите езикови модели могат да генерират и неправилни, подвеждащи или безсмислени отговори по различни причини. Някои примери за неуспехи на големите езикови модели и възможни причини и последствия са:

- Грешки при отричане: Възможно е големият езиков модел да не успее да се справи правилно с отрицанието, като например да произведе обратното на това, което е предвидено или се очаква. Например, когато е помолен да допълни изречение с отрицателно твърдение, големия езиков модел може да даде същия отговор като при положително твърдение. Това може да доведе до сериозни недоразумения, особено в области като здравеопазването или правото, тъй като моделът може да даде вреден съвет.

- Липса на разбиране: Моделите за учене през целия живот могат да усвоят формата на езика, без да притежават присъщите им езикови способности, които биха показали действително разбиране. Например те може да не са в състояние да разсъждават логически, да правят изводи за причинно-следствени връзки или да разрешават двусмислици. Това може да доведе до безсмислени или неуместни резултати, които не отразяват реалността или здравия разум. Например Galactica и ChatGPT са генерирали фалшиви научни статии за ползите от яденето на натрошено стъкло или добавянето на натрошен порцелан към кърмата.

- Проблеми с данните: Големия езиков модел може да наследи мненията, които съществуват в техните данни за обучение, като например невярна информация, широки расови стереотипи и обиден език. Например, Големият езиков модел може да генерира обидни отговори въз основа на самоличността или произхода на потребителя или темата на разговора. Това може да създаде значителни рискове за репутацията на доставчиците на тези модели.

- Халюцинации: Това е може би най-интересният от странните атрибути на големите езикови модели. В най-простата си форма моделите са склонни да си измислят неща. Това може да се дължи на факта, че в модела се вкарва случайност, когато се прогнозира следващият символ. Ако този случаен знак отведе модела по странна пътека на халюцинации, така да бъде.

Неотдавна имах опит с това, когато проверявах биографичната информация за мой приятел в Bing. По-конкретно, макар че Bing правилно идентифицира лицето като инвестиционен банкер, работещ за определена банка, той напълно неправилно му приписа транзакции по сливания и придобивания, които (а) той никога не е извършвал и (б) никога не са се случвали в реалния живот. Въпреки това моделът звучеше толкова уверено, че за момент си помислих, че може би паметта ми не ме е издържала.

Глупави са, но могат да бъдат полезни в някои ситуации

На този етап тези модели биха се оценили на нивото на стажант в колеж, който се нуждае от значителен надзор и чиито резултати трябва да бъдат проверени спрямо изходния материал. Въпреки това много компании използват стажанти от колежи за различни задачи. По-конкретно, смятам, че това е полезно, когато трябва да обобщя значително количество информация от различни източници или когато искам да получа бърз урок по изцяло нова тема. Въпреки това, винаги трябва да проверявате информацията от източника, ако е необходимо информацията да бъде наистина надеждна.

Ако сте открили някои допълнителни полезни неща, които могат да правят големите езикови модели, моля, напишете в коментарите. По същия начин, ако сте открили начини да объркате големите езикови модели или надеждни начини да определите кога разумно добре създаденото съдържание е генерирано от голям езиков модел.

Първоначално публикувано на Due Diligence and Art

Suggest a correction