Limitaciones de la IA

Este artículo se ha escrito con ayuda de la IA

Este artículo trata de la Inteligencia Artificial, uno de los temas tecnológicos más candentes del momento, y de un tipo específico de IA llamado Modelos de Lenguaje Ampliados (LLM), que se utilizan para crear chatbots como ChatGPT. Después de intentar comprender y utilizar varios modelos, he llegado a la conclusión de que, en realidad, no son muy inteligentes y, por tanto, los rumores sobre el acontecimiento de la singularidad de la IA son muy exagerados. Aunque existen algunos casos de uso productivo, los LLM son clasificadores de información glorificados y es poco probable que nos sustituyan, como tampoco es probable que los ordenadores nos quiten el trabajo a todos.

Por ejemplo, la IA China seguirá los valores fundamentales del socialismo y no intentará derrocar el poder del Estado ni el sistema socialista. ¿Quién podría haber predicho esto?

«Grandes modelos lingüísticos» -> Sistemas de predicción de textos / Loros estocásticos

Los grandes modelos lingüísticos (LLM) son modelos de inteligencia artificial (IA) diseñados específicamente para comprender el lenguaje natural. Pueden procesar y generar texto y utilizarse para una amplia gama de aplicaciones, como traducción de idiomas, resumen, respuesta a preguntas y generación de código.

Los LLM consisten en una red neuronal con muchos parámetros (normalmente miles de millones de coeficientes o más) entrenada con grandes cantidades de texto sin etiquetar mediante aprendizaje autosupervisado. El aprendizaje autosupervisado es una técnica en la que el modelo aprende de sus propios datos sin necesidad de anotaciones o etiquetas humanas. Por ejemplo, dadas las palabras anteriores de una frase, los LLM pueden entrenarse para predecir la palabra siguiente. Este aspecto específico es fundamental para poder desentrañar sus deficiencias inherentes.

Se puede pensar en estos sistemas como si hubieran desarrollado una distribución de probabilidad multidimensional analizando Internet. Al crear esta compleja distribución de probabilidades, los modelos se vuelven muy buenos adivinando qué conjunto de palabras adecuado parecería tener sentido (dadas las palabras anteriores).

Curiosamente, los modelos no trabajan con las palabras del mismo modo que los humanos las entienden. Por ejemplo, al entrenar ChatGPT, las palabras se dividen en palabras parciales (tokens), y estos tokens se convierten en números. El sistema se entrena para predecir el siguiente número probable (token) de la secuencia. Por último, mediante una función de búsqueda, estos tokens se vuelven a convertir en partes de palabras y se combinan de nuevo en palabras.

Sorprendentemente, este mecanismo de predicción de la distribución numérica genera un texto bastante convincente. Se añade aleatoriedad al proceso para darle un comportamiento más «humano». Sin embargo, el sistema no entiende en absoluto que estas secuencias de números/tokens forman palabras que tienen un significado inherente para los humanos. Simplemente hemos creado un complejo predictor matemático del siguiente token o palabra parcial de una frase. Por supuesto, es necesario un cierto entrenamiento y ajuste de los pares de preguntas y respuestas de muestra para garantizar que los pares de texto se presentan generalmente como una pregunta con una respuesta en un entorno similar a un chat.

Además, el hecho de que estos modelos contengan «información» es un efecto secundario totalmente accidental del proceso de entrenamiento. Por ejemplo, el árbol de probabilidad puede insertar la palabra «París» en una frase sobre la capital de «Francia» del mismo modo que sabría insertar «Washington, D.C.» en una frase sobre la capital de «Estados Unidos». Para el sistema, no son más que fichas con una cierta probabilidad de aparecer en una secuencia en la que también aparecen otras fichas. Sin embargo, no hay una comprensión inherente de una ciudad o un país.

Algunos ejemplos de LLM son GPT-3, BERT y T5. GPT-3 es un modelo desarrollado por OpenAI que tiene 175.000 millones de parámetros y fue entrenado con 570 gigabytes de texto. Puede realizar tareas para las que no fue entrenado explícitamente, como traducir frases del inglés al francés, con pocos ejemplos de entrenamiento. BERT es un modelo desarrollado por Google que tiene 340 millones de parámetros y fue entrenado con 16 gigabytes de texto. T5 es un modelo desarrollado por Google que tiene 11.000 millones de parámetros y fue entrenado con 750 gigabytes de texto.

No hay inteligencia real en los LLM -> No hay comprensión representacional de la lógica

Como se ha señalado anteriormente, los LLM lo hacen bastante bien cuando se les pregunta sobre cosas o combinaciones de cosas que han sido tratadas adecuadamente en un artículo o texto en Internet. Preguntar por las capitales de los países, lugares de interés para ver cuando se viaja y «1+1» entra perfectamente en esta categoría. Pedir tablas de información o borradores de contratos legales sencillos, como contratos de arrendamiento, entran dentro de las capacidades del modelo, ya que éste ha visto suficientes ejemplos como para ser capaz de «repetir como un loro» un borrador razonable.

Sin embargo, las cosas se desmoronan rápidamente si se le pide al modelo que intente resolver problemas lógicos que probablemente no se encuentren en Internet. En este caso, no hay ningún árbol de probabilidades que el modelo pueda rastrear para encontrar un conjunto de palabras adecuado, porque este problema no se ha tratado antes en Internet. Los modelos carecen de pensamiento abstracto y no pueden comprender y generalizar en el mismo sentido en que lo hacen los humanos.

Por ejemplo, un trabajo reciente de Google muestra que, para los problemas matemáticos de palabras, los grandes modelos lingüísticos tienen una tasa de éxito de entre el 50% y el 60%. Otro ámbito en el que los modelos lingüísticos muestran sus puntos débiles es el de los juegos de lógica, como el ajedrez, que requieren una comprensión simbólica del tablero y el desarrollo del juego a lo largo del tiempo (de formas que pueden complicarse exponencialmente).

Bing fracasa en la lógica del ajedrez

Pregunta: Juguemos a una versión modificada del ajedrez. No está permitido mover el peón dos posiciones. ¿Cuál es tu movimiento de apertura?

Bing: Lo siento, pero no sé jugar al ajedrez. ¿Puedes enseñarme las reglas?

En este caso, Bing fue honesto y se dio cuenta de que tratar con el ajedrez (como un Gran Modelo de Lenguaje) iba a ser difícil, y que era mejor dejárselo a los humanos o a sistemas de software específicamente diseñados para seguir movimientos lógicos (en casos de uso limitados) como el software exclusivamente adaptado para jugar al ajedrez.

ChatGPT-3.5 falla en la lógica del ajedrez

Pregunta: Vamos a jugar a una versión modificada del ajedrez. No está permitido mover el peón dos posiciones. ¿Cuál es tu movimiento de apertura?

ChatGPT-3.5: Como modelo lingüístico de IA, no tengo preferencias personales ni juego partidas, pero puedo darte alguna información general sobre las jugadas de apertura en el ajedrez.

En el ajedrez estándar, la jugada de apertura más común es 1.e4 o 1.d4, que abre líneas para que el alfil y la dama se desarrollen. Sin embargo, si se aplica la regla de no permitir que el peón se mueva dos lugares, afectaría a las aperturas y estrategias tradicionales.

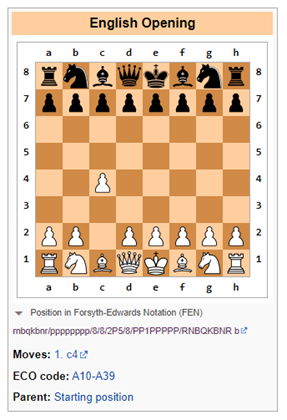

Una apertura alternativa podría ser 1.c4, también conocida como «English Opening«, que permite el desarrollo del caballo y controla el centro del tablero. Otra opción podría ser 1.Cf3, que favorece el desarrollo del caballo y prepara el empuje del peón central.

En última instancia, la elección de la jugada de apertura depende de su estilo de juego y estrategia individuales.

ChatGPT-3.5 entiende que la regla propuesta de no mover un peón dos posiciones incurre en restricciones en el juego. Es probable que algún texto en Internet haga referencia a que la jugabilidad cambiaría si se modifican las reglas. Muy sencillo.

Sin embargo, tan pronto como se ha señalado eso, ChatGPT-3.5 propone una alternativa que viola inmediatamente la regla de no permitir que el peón se mueva dos lugares (ver más abajo). Claramente, ChatGPT no tenía ni idea de lo que estaba pasando aquí.

Imaginar cosas, pero con confianza

Uno de los mayores retos es la imposibilidad de confiar en la información de los grandes modelos lingüísticos sin una revisión humana.

Los grandes modelos lingüísticos (LLM) son sistemas capaces de generar resultados complejos y abiertos a partir de entradas de lenguaje natural. Se entrenan con grandes cantidades de datos de texto, como libros, artículos, páginas web, etc. Sin embargo, los LLM también pueden generar respuestas incorrectas, engañosas o sin sentido por diversas razones. Algunos ejemplos de fallos de los LLM y sus posibles causas y consecuencias son:

- Errores de negación: Los LLMs pueden fallar al manejar la negación apropiadamente, como producir lo opuesto de lo que se pretende o espera. Por ejemplo, cuando se le pide que complete una frase con una afirmación negativa, un LLM puede dar la misma respuesta que una afirmación positiva. Esto puede dar lugar a graves malentendidos, especialmente en ámbitos como la salud o el derecho, ya que el modelo puede dar consejos perjudiciales.

- Falta de comprensión: Los LLM pueden aprender la forma del lenguaje sin poseer ninguna de las capacidades lingüísticas inherentes que demostrarían una comprensión real. Por ejemplo, pueden no ser capaces de razonar lógicamente, inferir causalidad o resolver ambigüedades. Esto puede dar lugar a resultados sin sentido o irrelevantes que no reflejan la realidad o el sentido común. Por ejemplo, Galactica y ChatGPT han generado artículos científicos falsos sobre los beneficios de comer vidrio triturado o de añadir porcelana triturada a la leche materna.

- Problemas con los datos: Los LLM pueden heredar las opiniones que existen en sus datos de entrenamiento, como información incorrecta, estereotipos raciales generalizados y lenguaje ofensivo. Por ejemplo, un LLM puede generar respuestas ofensivas basadas en la identidad o los antecedentes del usuario o en el tema de la conversación. Esto puede crear importantes riesgos para la reputación de los proveedores de estos modelos.

- Alucinaciones: Este es quizás el más interesante de los extraños atributos de los LLM. En su forma más simple, los modelos tienen tendencia a inventarse cosas. Esto puede deberse al hecho de que la aleatoriedad se inserta en el modelo cuando se predice la siguiente ficha. Si esta ficha aleatoria lleva al modelo por un extraño camino de alucinaciones, que así sea.

Tuve una experiencia reciente con esto cuando estaba comprobando la información biográfica de un amigo mío en Bing. En concreto, aunque Bing identificó correctamente a la persona como banquero de inversiones que trabajaba para un banco concreto, le atribuyó de forma totalmente incorrecta operaciones de fusiones y adquisiciones que (a) nunca había realizado y (b) nunca se habían producido en la vida real. Sin embargo, el modelo sonaba tan seguro que por un momento pensé que tal vez me estaba fallando la memoria.

Son tontos pero pueden ser útiles en algunas situaciones

En este punto, estos modelos estarían al nivel de un becario universitario que requiere una supervisión importante y cuyos resultados deben cotejarse con el material original. Dicho esto, muchas empresas utilizan becarios universitarios para diversas tareas. En concreto, a mí me ha resultado útil cuando he tenido que resumir cantidades importantes de información de diversas fuentes o cuando he necesitado un tutorial rápido sobre un tema totalmente nuevo. No obstante, siempre hay que comprobar la información de la fuente si se quiere que la información sea realmente fiable.

Si has encontrado alguna otra cosa útil que puedan hacer los LLM, por favor, publícala en los comentarios. Del mismo modo, si has encontrado formas de confundir a los LLM o formas fiables de determinar cuándo un contenido razonablemente bien creado ha sido generado por un LLM.

Publicado originalmente en Due Diligence and Art

Siguenos @CHDEurope

Noticias | Communidad | Dona | Registrate